深度学习4:机器学习基础_机器学习处理数据冗余的模型有哪些-程序员宅基地

之前的三类机器学习问题分别是二分类问题,多分类问题,标量回归问题,这三者都是监督学习的例子,目标是学习训练输入与训练目标之间的关系。

机器学习四个分支:监督学习,无监督学习,自监督学习,强化学习

分类与回归术语表

| 名称 | 描述 |

|---|---|

| 样本或输入 | 进入模型的数据点 |

| 预测或输出 | 从模型出来的结果 |

| 目标 | 真实值,对于外部数据源,理想情况下,模型应该能够预测出目标 |

| 预测误差或损失值 | 模型预测与目标之间的距离 |

| 类别 | 分类问题中供选择的一组标签,例如猫狗分类的猫或狗 |

| 标签 | 分类问题中类别标注的具体例子 ,比如1234号图像被标注为包含类别“狗”,狗就是1234号图像的标签 |

| 真值或标注 | 数据集的所有目标,通常由人工收集 |

| 二分类 | 一种分类任务,每个输出样本都应被分到两个互斥类别中 |

| 多分类 | 一种分类任务,每个输出样本都应被分到两个以上的类别中,比如手写数字分类 |

| 多标签分类 | 一个分类任务,每个输入样本都可以分配多个标签,比如一个图像既有猫又有狗 |

| 标量回归 | 目标是连续标量值的任务,预测房价就是一个很好的例子,不同的目标价格形成连续的空间 |

| 向量回归 | 目标是一组连续值的任务,如果对多个值进行回归,那就是向量回归 |

| 小批量或批量 | 模型同时处理的一小部分样本(样本数通常为8-128),样本数取2的幂,这样便于GPU的内存分配,训练时,小批量用来为模型权值计算一次梯度下降更新 |

机器学习的目的是得到可以泛化的模型,也就是在前所未有的数据上表现很好的模型,过拟合是核心难点。

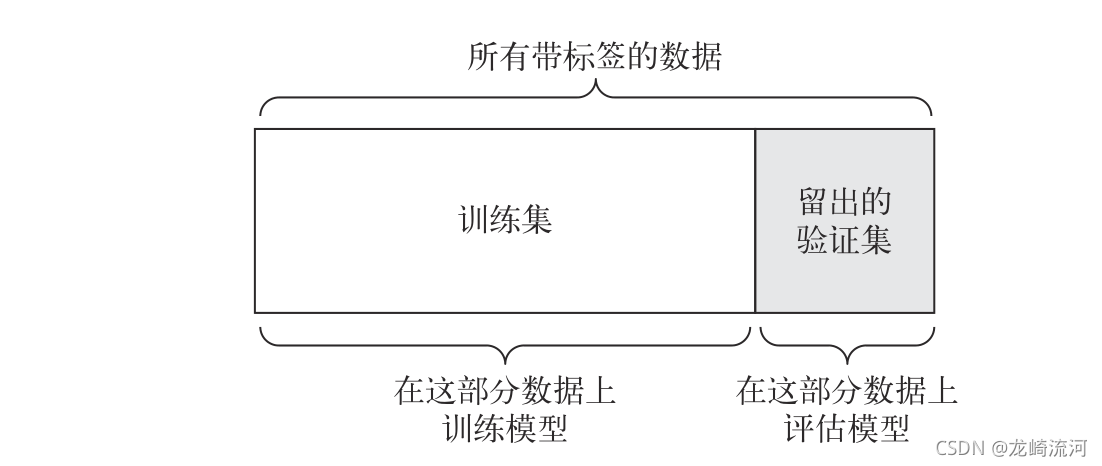

训练集,验证集,测试集

在训练数据上训练模型,在验证数据上评估模型,一旦找到了最佳参数,就在测试数据上最后测试一次。

模型一定不能读取与测试集相关的任何信息,即使间接读取也不可以,如果基于测试集性能来调节模型,那么对泛化的衡量不准确。

信息泄露

每次基于模型在验证集上的性能来调节模型超参数,都会有一些关于验证数据的信息泄露在模型中,如果对每个参数只调节一次,那么泄露的信息很少,验证集仍然可以可靠地评估模型。但如果多重复这一过程(也就是运行一次实验,在验证集上评估,然后据此修改模型),那么将会有越来越多的关于验证集的信息泄露在模型中。

三种经典评估方法

简单留出验证

·

num_validation_samples = 10000

#需要打乱数据

np.random.shuffle(data)

validation_ _data = data[ :num_ _validation_ _samples]

data = data[num_ _validation_ samples: ]

training_data = data[:]

model = get_model ()

model.train(training_ _data)

#在训练数据.上训练模型,

validation_score = model. evaluate (validation_data)

#并在验证数据上评估模型

#现在你可以调节模型、重新训练、评估,然后再次调节......

model = get_model()

mode.train (np . concatenate( [training_data,

validation_data] ) )

#一旦调整好超参数,通常在所有非测试数据上从头开始训练最终模型

test_ score = model . evaluate (test_data)

这是最简单的评估方法,但有一个缺点:如果可用的数据很少,那么可能验证集和测试集包含的样本就太少,从而无法在统计学上代表数据。这个问题很容易发现:如果在划分数据前进行不同的随机打乱,最终得到的模型性能差别很大,那么就存在这个问题。接下来会介绍K折

验证与重复的K折验证,它们是解决这一问题的两种方法。

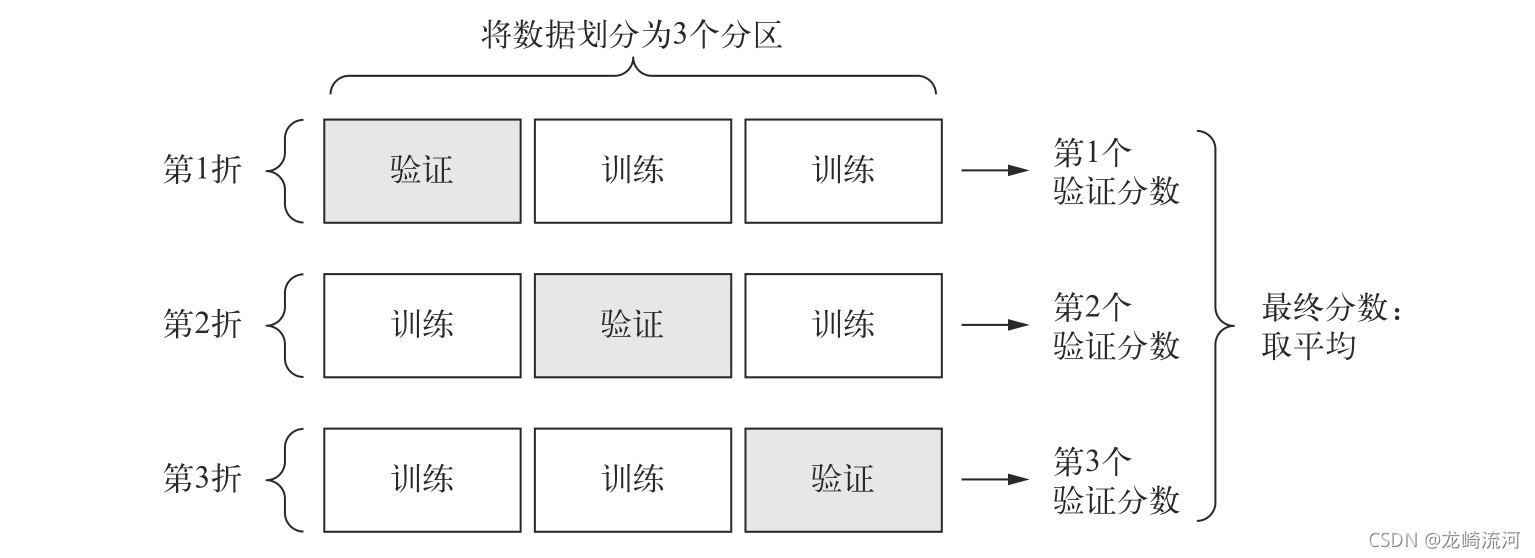

k折交叉验证

K折验证( K-fold validation)将数据划分为大小相同的K个分区。对于每个分区i,在剩余的K-1个分区上训练模型,然后在分区i上评估模型。最终分数等于K个分数的平均值。对于不同的训练集-测试集划分,如果模型性能的变化很大,那么这种方法很有用。与留出验证一样,这种方法也需要独立的验证集进行模型校正。

k=4

num_validation_ samples = len(data) // k

np. random.shuffle (data)

validation_scores = []

for fold in range(k):

#选择验证数据分区

validation_data = data [num_validation_samples * fold:

num_validation_samples * (fold + 1)]

#使用剩余数据作为训练数据,注意+运算符是列表合并

training_data = data[:num_validation_samples * fold] +

data[num_validation_ samples * (fold + 1) :]

#创建一个全新的模型实例(未训练)

model = get_model ()

model.train(training_data)

validation_score = model.evaluate(validation_data)

validation_scores.append (validation_score)

#最终验证分数:k折验证分数的平均值

validation_score = np.average(validation_scores)

#在所有非测试数据上训练最终模型

model = get_model()

model.train(data)

test_score = model.evaluate(test_data)

带有打乱数据的重复k折验证

多次使用k折验证,在每次将数据划分为k个分区之前都将数据打乱,最终分数是每次k折验证分数的平均值,这种方法一共需要训练和评估p乘以k个模型(p是重复次数),计算代价很大。

评估模型注意点:

- 数据代表性,在将数据划分为训练集和测试集之前,通常应该随机打乱数据。

- 时间箭头,如果要预测未来,那么在划分数据前不应该随机打乱数据,这么做可能会造成时间泄露,这种情况下应该保证测试集中所有数据的时间都晚于训练集数据。

- 数据冗余,一定要确保训练集和验证集之间没有交集。

数据预处理

目的是使原始数据更适用于用神经网络处理,包括向量化,标准化。处理缺失值和特征提取。

向量化:

无论处理什么数据(声音,图像还是文本),都必须首先将其转换为张量,这一步叫数据向量化

值标准化:

一般来说,将取值相对较大的数据或异质数据(比如数据的一个特征在0-1范围内,另一个特征在100-200范围内)输入到神经网络中是不安全的,这么做可能导致较大的梯度更新,进而导致网络无法收敛,为了让网络的学习变得更容易,输入数据应该具有以下特征:1,取值较小:大部分值都应该在0-1范围内。2,同质性:所有特征的取值都应该在大致相同的范围内。

x -=x.mean(axis=0)

x /=x.std(axis=0)

过拟合和欠拟合

优化:调节模型以在训练数据上得到最佳性能,泛化是指训练好的模型在前所未有的数据上的性能好坏。

训练数据上损失的越少,测试数据上的损失也越小,这时的模型是欠拟合的,即仍有改进的空间。

在训练数据上迭代一定次数之后,泛化不再提高,验证指标先是不变,然后开始变差就是模型的过拟合。

为了防止模型从训练数据中学到错误或无关紧要的模式,最优的解决方法是获取更多的训练数据,模型的训练数据越多,泛化能力自然越好,次优解决方法是调节模型允许存储的信息量,或对模型允许存储信息加以约束。

防止过拟合的最简单的方法就是减小模型大小,也就是减少模型中可学习参数的个数(这由层数和每层的单元个数决定),网络的容量越大,它拟合训练数据的速度就越快,但也更容易过拟合(训练数据和验证损失由很大差异)。

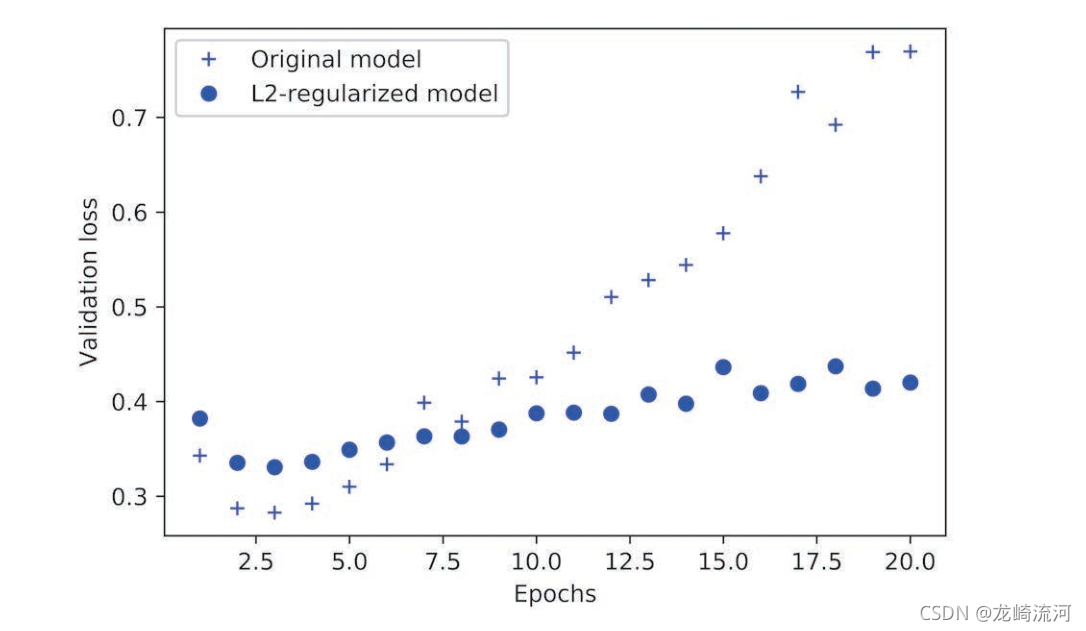

一种常见的降低过拟合的方法就是强制让模型权值只能取较小的值,从而限制模型的复杂度,这使得权重值的分布更加规则,这种方法叫权值正则化,其实现方法是向网络损失函数中添加与较大权重值相关的成本。

model = models.Sequential()

model.add(layers.Dense(64, kernel_regularizer=regularizer.l2(0.001),activation='relu', input_shape=(10000,)))

model.add(layers.Dense(64, kernel_regularizer=regularizer.l2(0.001),activation='relu'))

model.add(layers.Dense(1),activation='sigmoid')

l2(0.001)的意思是该层权重矩阵的每个系数都会使网络总损失增加0.001*weight_coefficient_value,这个惩罚项只在训练时添加,所以这个网络的训练损失会比测试损失大很多。

from tensorflow.keras import regularizers

#l1正则化

regularizers.l1(0.001)

#同时做l1和l2正则化

regularizers.l1_l2(l1=0.001,l2=0.001)

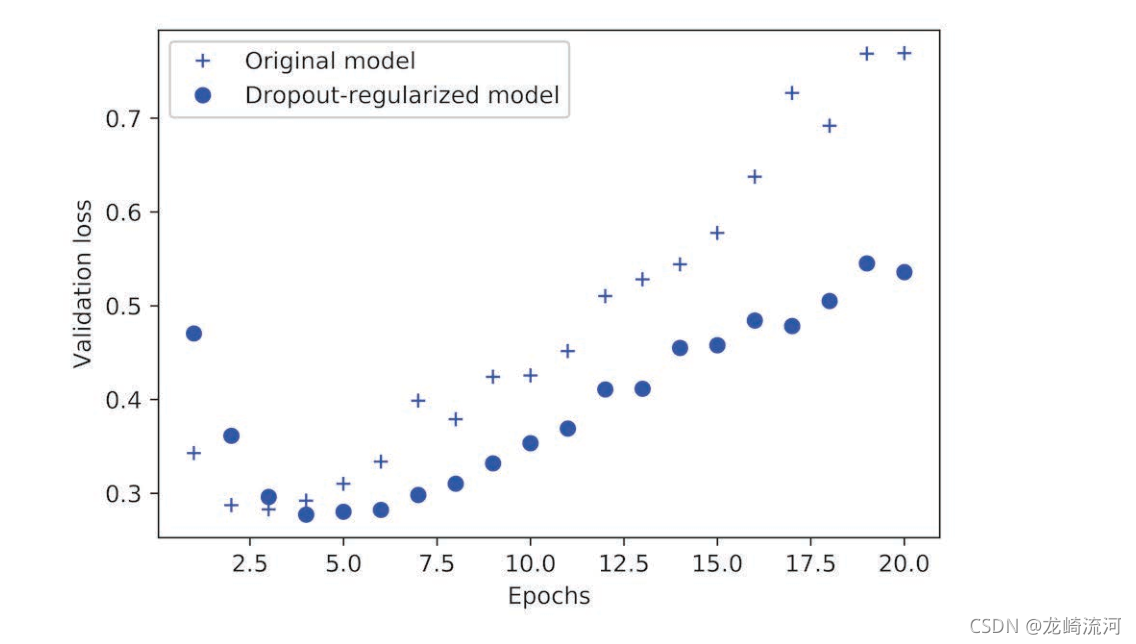

添加dropout正则化,对某一层使用dropout,就是在训练过程中随机将该层的一些输出特征舍弃(设置为0),假设在训练过程中,某一层对给定输入样本的返回值应该时向量[0.2,0.5,1.3,0.8,1.1],使用dropout后,这个向量会有几个随机的元素变成0,比如[0,0.5,1.3,0,1.1]。dropout比率也就是被设为0的特征所占的比例,通常在0.2-0.5范围内,测试时没单元被舍弃,而该层的输出值需要按dropout比率缩小,因为此时比训练时由更多单元被激活,需要加以平衡。

在每个样本中随机删除不同的部分神经元,可以阻止它们的阴谋,因此可以降低过拟合,其核心思想在层的输出值中引入噪声,打破不显著的偶然模式,如果没有噪声的话,网路将会记住这些偶然模式。

model = models.Sequential()

model.add(layers.Dense(64,activation='relu', input_shape=(10000,)))

model.add(layers.Dropout(0.5))

model.add(layers.Dense(64,activation='relu'))

model.add(layers.Dropout(0.5))

model.add(layers.Dense(1),activation='sigmoid')

总之,防止神经网络过拟合的常用方法包括:获取更多训练数据,减少网络容量,添加权重正则化,添加dropout。

智能推荐

攻防世界_难度8_happy_puzzle_攻防世界困难模式攻略图文-程序员宅基地

文章浏览阅读645次。这个肯定是末尾的IDAT了,因为IDAT必须要满了才会开始一下个IDAT,这个明显就是末尾的IDAT了。,对应下面的create_head()代码。,对应下面的create_tail()代码。不要考虑爆破,我已经试了一下,太多情况了。题目来源:UNCTF。_攻防世界困难模式攻略图文

达梦数据库的导出(备份)、导入_达梦数据库导入导出-程序员宅基地

文章浏览阅读2.9k次,点赞3次,收藏10次。偶尔会用到,记录、分享。1. 数据库导出1.1 切换到dmdba用户su - dmdba1.2 进入达梦数据库安装路径的bin目录,执行导库操作 导出语句:./dexp cwy_init/[email protected]:5236 file=cwy_init.dmp log=cwy_init_exp.log 注释: cwy_init/init_123..._达梦数据库导入导出

js引入kindeditor富文本编辑器的使用_kindeditor.js-程序员宅基地

文章浏览阅读1.9k次。1. 在官网上下载KindEditor文件,可以删掉不需要要到的jsp,asp,asp.net和php文件夹。接着把文件夹放到项目文件目录下。2. 修改html文件,在页面引入js文件:<script type="text/javascript" src="./kindeditor/kindeditor-all.js"></script><script type="text/javascript" src="./kindeditor/lang/zh-CN.js"_kindeditor.js

STM32学习过程记录11——基于STM32G431CBU6硬件SPI+DMA的高效WS2812B控制方法-程序员宅基地

文章浏览阅读2.3k次,点赞6次,收藏14次。SPI的详情简介不必赘述。假设我们通过SPI发送0xAA,我们的数据线就会变为10101010,通过修改不同的内容,即可修改SPI中0和1的持续时间。比如0xF0即为前半周期为高电平,后半周期为低电平的状态。在SPI的通信模式中,CPHA配置会影响该实验,下图展示了不同采样位置的SPI时序图[1]。CPOL = 0,CPHA = 1:CLK空闲状态 = 低电平,数据在下降沿采样,并在上升沿移出CPOL = 0,CPHA = 0:CLK空闲状态 = 低电平,数据在上升沿采样,并在下降沿移出。_stm32g431cbu6

计算机网络-数据链路层_接收方收到链路层数据后,使用crc检验后,余数为0,说明链路层的传输时可靠传输-程序员宅基地

文章浏览阅读1.2k次,点赞2次,收藏8次。数据链路层习题自测问题1.数据链路(即逻辑链路)与链路(即物理链路)有何区别?“电路接通了”与”数据链路接通了”的区别何在?2.数据链路层中的链路控制包括哪些功能?试讨论数据链路层做成可靠的链路层有哪些优点和缺点。3.网络适配器的作用是什么?网络适配器工作在哪一层?4.数据链路层的三个基本问题(帧定界、透明传输和差错检测)为什么都必须加以解决?5.如果在数据链路层不进行帧定界,会发生什么问题?6.PPP协议的主要特点是什么?为什么PPP不使用帧的编号?PPP适用于什么情况?为什么PPP协议不_接收方收到链路层数据后,使用crc检验后,余数为0,说明链路层的传输时可靠传输

软件测试工程师移民加拿大_无证移民,未受过软件工程师的教育(第1部分)-程序员宅基地

文章浏览阅读587次。软件测试工程师移民加拿大 无证移民,未受过软件工程师的教育(第1部分) (Undocumented Immigrant With No Education to Software Engineer(Part 1))Before I start, I want you to please bear with me on the way I write, I have very little gen...

随便推点

Thinkpad X250 secure boot failed 启动失败问题解决_安装完系统提示secureboot failure-程序员宅基地

文章浏览阅读304次。Thinkpad X250笔记本电脑,装的是FreeBSD,进入BIOS修改虚拟化配置(其后可能是误设置了安全开机),保存退出后系统无法启动,显示:secure boot failed ,把自己惊出一身冷汗,因为这台笔记本刚好还没开始做备份.....根据错误提示,到bios里面去找相关配置,在Security里面找到了Secure Boot选项,发现果然被设置为Enabled,将其修改为Disabled ,再开机,终于正常启动了。_安装完系统提示secureboot failure

C++如何做字符串分割(5种方法)_c++ 字符串分割-程序员宅基地

文章浏览阅读10w+次,点赞93次,收藏352次。1、用strtok函数进行字符串分割原型: char *strtok(char *str, const char *delim);功能:分解字符串为一组字符串。参数说明:str为要分解的字符串,delim为分隔符字符串。返回值:从str开头开始的一个个被分割的串。当没有被分割的串时则返回NULL。其它:strtok函数线程不安全,可以使用strtok_r替代。示例://借助strtok实现split#include <string.h>#include <stdio.h&_c++ 字符串分割

2013第四届蓝桥杯 C/C++本科A组 真题答案解析_2013年第四届c a组蓝桥杯省赛真题解答-程序员宅基地

文章浏览阅读2.3k次。1 .高斯日记 大数学家高斯有个好习惯:无论如何都要记日记。他的日记有个与众不同的地方,他从不注明年月日,而是用一个整数代替,比如:4210后来人们知道,那个整数就是日期,它表示那一天是高斯出生后的第几天。这或许也是个好习惯,它时时刻刻提醒着主人:日子又过去一天,还有多少时光可以用于浪费呢?高斯出生于:1777年4月30日。在高斯发现的一个重要定理的日记_2013年第四届c a组蓝桥杯省赛真题解答

基于供需算法优化的核极限学习机(KELM)分类算法-程序员宅基地

文章浏览阅读851次,点赞17次,收藏22次。摘要:本文利用供需算法对核极限学习机(KELM)进行优化,并用于分类。

metasploitable2渗透测试_metasploitable2怎么进入-程序员宅基地

文章浏览阅读1.1k次。一、系统弱密码登录1、在kali上执行命令行telnet 192.168.26.1292、Login和password都输入msfadmin3、登录成功,进入系统4、测试如下:二、MySQL弱密码登录:1、在kali上执行mysql –h 192.168.26.129 –u root2、登录成功,进入MySQL系统3、测试效果:三、PostgreSQL弱密码登录1、在Kali上执行psql -h 192.168.26.129 –U post..._metasploitable2怎么进入

Python学习之路:从入门到精通的指南_python人工智能开发从入门到精通pdf-程序员宅基地

文章浏览阅读257次。本文将为初学者提供Python学习的详细指南,从Python的历史、基础语法和数据类型到面向对象编程、模块和库的使用。通过本文,您将能够掌握Python编程的核心概念,为今后的编程学习和实践打下坚实基础。_python人工智能开发从入门到精通pdf