2021电赛F题-智能送药小车-国一_电赛送药小车国一多少分-程序员宅基地

2021电赛F题-智能送药小车-国一

B站视频链接:https://www.bilibili.com/video/BV1u44y1e7qk/

(这大概是b站第一个双车视频吧,嘿嘿)

全部代码开源-下载链接:

https://download.csdn.net/download/my_id_kt/76744664

https://github.com/gxt-kt/2021-F-drug_car

两个内容都一样,(记得先看readme哈)

有任何问题欢迎评论或者私信

文章目录

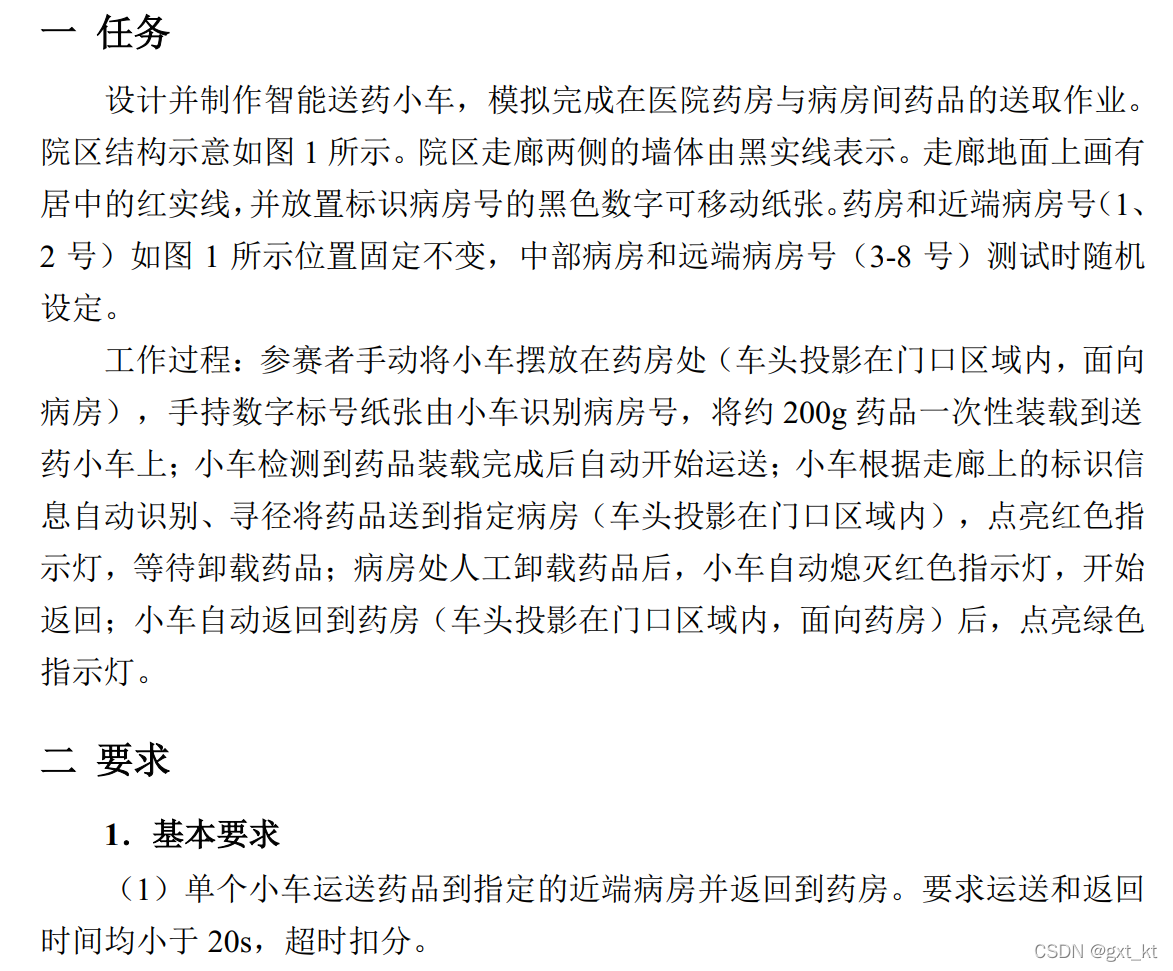

一、原题(了解可以跳过)

二、赛题分析

分析可知道这道题主要是以下几点:

1.巡线实现

2.数字识别实现

3.巡线找药房算法实现

1.巡线实现

最开始的想法是使用红外循迹模块,但由于之前使用过,再加上场地没到,等到数字识别有思路了再开始看巡线模块,发现坏了!普通的光电根本识别不了,当时立马就去淘宝上买那种改成光敏电阻的巡线模块,感觉快递有点来不及(广东到南京),巡线是赛题的基础,根本等不了两天的快递,立马把方案换成openmv寻找中线,由我的一名队友全部负责,差不多第二天晚上就可以了。

具体思路是把一副完整图像分块,分好了分别找红色色块,结合图像中间和边缘红块,可以很容易得到线的中心和十字路口信息。效果很稳定。

2.数字识别实现

最开始数字识别是打算用openmv模板匹配的,第一天上午发现不行,倒不是不行,就是成功率,帧率感人,我们队从始至终都是想不停车识别的,就那个帧率成功率想不停车都难,果断换成k210,第一天拍了几百张,训练出来效果也不行,当时心态就有点崩,感觉死在了第一步,第二天我的主搞k210队友提出也许是昨天拍的训练集离数字太远了,这次换成20~25cm左右的照片训练集,虽然当时就拍了几百张,效果就立竿见影了,k210的成功率也很高,基本上80%以上,对于一些不容易误识别的基本都是90%+,也就是那时候感觉差不多了开始搞巡线了。

3.巡线找药房实现

这个主要是openmv和k210的效果好,调第一辆车的时候没遇见什么难的,大致流程就是

// 开始识别数字+寻线—>//

识别到第个十字路口// 识别到停车边界—>停车亮灯—>

根据已经存储到的k210数字判断走向—>

重复流程

大致流程是上面那样,关键点就是识别十字路口,并且在走过一次十字路口后清空上次存储的数字,开始重新识别

三、other细节

当时发送赛道某个别拐角会让k210误识别成7,但发现这时候的7识别率都只有5,6成,所以当时就在k210代码里加入识别率的阈值,只有高于一定值的数字才会被认作有效

1.k210,openmv都是通过串口通信

串口通信用的接收中断加空闲中断,为啥不用dma,因为这次我们车上包括调试,双车通信,串口占用率很高,根据经验用dma多串口有概率丢帧,所以基本都是用的接收中断,空闲中断也就几个用了。

2.我们用了两个k210,识别不停车

1.k210本身帧率不算低,当时本来想关闭屏幕显示再提高帧率的,发现并不明显,估计屏幕发送显示本身也用了dma,后来也就一直开着也方便调试

2.k210的识别是弄一个8个的数组,每帧识别到哪个数字对应的数组值会加1,所以我们只需要排序这个数组就知道识别到的数字是谁了

3.k210会在走廊尽头同时识别两个数字,所以用到了一个算法,找一堆乱序数字中最大的两个数,使用这个算法后也就解决了两个数字识别问题

4.其实以上关于k210或者openmv都用了很多阈值判断或者滤波判断来减少误差或者误判,但没必要说的很详细,就把一些关键一点的说了比如前文k210解决误识别数字7的问题。

3.巡回算法

3.1小车怎么知道回来的路怎么走呢: 我们定义一个数组,每次碰到十字路口就记录下当前走向,比如说左转弯计1,直走计2,右转弯计3,如果右碰到十字路口就记录第二次走向,以此类推,当走到药房时我们就已经知道之前是怎么走过来的了。

3.2形象点描述:你去找人问题,他会说往前走多少米右拐,再一直走,碰到小巷左拐,走到底就到了

这道题就忽略掉距离信息,只看拐弯点和拐弯点的走向。

3.3接着上文: 我们的小车在回来的时候只需要倒着看拐弯点就可以了,走到十字路口,看你上次怎么走的,上次直走这次也直走,上次左拐这次就右拐,遍历完你之前写的数组就能回到原位了。

4.电机控制

由于时间紧迫,并且当时不认为本题难点在这里,就只实现了单环速度PID控制,建议大家有时间写个电机速度位置双环算法。这也是我认为我们在这道题前期准备中缺失的一个小点。

5.双车控制

其实我们第二辆车很破旧,电机十分垃圾,重要的是我在4.电机控制那里的PID参数用不了,由于是另外两个临时凑的电机,pid参数都得变,这也是我们最难受的一点,我们大概在第三天中午就已经完全完成了第一辆车的功能,第二辆车由于车模和芯片问题,一直出问题,说实话我们三个人被第二辆车搞的心力交瘁,当时都想不搞扩展了,后来发现是主控芯片坏了,我就用热风枪吹了下来,换了一块开发板上的芯片上去。(一直没查出来的原因是这块芯片能正常下程序,rcc正常,led闪烁正常,就是串口和某些io引脚彻底损坏,就一直没怀疑到芯片头上去)到这已经是最后一天下午了,我们赶着2号车勉强能用的条件下花了5个小时把扩展功能写了,至此比赛封箱,完结。

至此其实无论思路还是实现方案已经分析完了,后面就是贴代码贴图环节

openmv代码

# Hello World Example

#

# Welcome to the OpenMV IDE! Click on the green run arrow button below to run the script!

import pyb, sensor, image, math, time

from pyb import UART

import json

uart = UART(3,115200)

red_threshold = [(71, 25, 98, 19, 101, -14)]

black_threshold = [(0, 42, -84, 19, -104, 32)]

#QVGA 320*240

roi_1 = [(40, 0, 240, 40), # 北

(40, 200, 160, 40), # 南

(0, 0, 40, 240), # 西

(280, 0, 40, 240), # 东

(30,80,300,80)] # 中

sensor.reset() # 初始化摄像头

sensor.set_pixformat(sensor.RGB565) # 格式为 RGB565.

sensor.set_framesize(sensor.QVGA)

sensor.skip_frames(20) # 跳过10帧,使新设置生效

sensor.set_auto_whitebal(False) # turn this off.

sensor.set_auto_gain(False) # must be turned off for color tracking

clock = time.clock()

buf =[0 for i in range(5)]

m = -1

zhong_x = 0

zhong_y = 0

bei_x = 0

bei_y = 0

nan_x = 0

nan_y = 0

dong_x = 0

dong_y = 0

xi_x = 0

xi_y = 0

black_num = 0

threshold_pixel = 280

uart.init(115200, bits=8, parity=None, stop=1)

def pack_dot_data():

pack_data=bytearray([0xAA,0xFF,zhong_x>>8,zhong_x,dong_y>>8,dong_y,xi_y>>8,xi_y,

black_num,0x00,0x00])

lens = len(pack_data) #数据包大小

#pack_data[3] = lens-6; #有效数据个数

sc = 0

ac = 0

i = 0

while i<(lens-1):

sc = sc + pack_data[i]

ac = ac + sc

i=i+1

pack_data[lens-2] = sc

pack_data[lens-1] = ac;

return pack_data

while(True):

clock.tick()

m = -1

isten = 0

black_num = 0

img = sensor.snapshot().lens_corr(strength = 1.8, zoom = 1.0)

for r in roi_1:

m += 1

blobs = img.find_blobs(red_threshold, roi=r[0:4],pixels_threshold=100, area_threshold=100, merge=True)

#img.draw_rectangle(r[0:4], color=(255,0,0))

if blobs:

most_pixels = 0

largest_blob = 0

for i in range(len(blobs)):

#目标区域找到的颜色块(线段块)可能不止一个,找到最大的一个,作为本区域内的目标直线

if blobs[i].pixels() > most_pixels:

most_pixels = blobs[i].pixels()

#merged_blobs[i][4]是这个颜色块的像素总数,如果此颜色块像素总数大于

largest_blob = i

#print(blobs[largest_blob].cx(),blobs[largest_blob].cy())

if m == 0:

bei_x = blobs[largest_blob].cx()

bei_y = blobs[largest_blob].cy()

elif m == 1:

nan_x = blobs[largest_blob].cx()

nan_y = blobs[largest_blob].cy()

elif m == 2:

dong_x = blobs[largest_blob].cx()

dong_y = blobs[largest_blob].cy()

elif m == 3:

xi_x = blobs[largest_blob].cx()

xi_y = blobs[largest_blob].cy()

elif m == 4:

zhong_x = blobs[largest_blob].cx()

zhong_y = blobs[largest_blob].cy()

# Draw a rect around the blob.

img.draw_rectangle(blobs[largest_blob].rect())

#将此区域的像素数最大的颜色块画矩形和十字形标记出来

img.draw_cross(blobs[largest_blob].cx(),

blobs[largest_blob].cy())

buf[m] = 1

else:

buf[m] = 0

if m == 0:

bei_x = 0

bei_y = 0

elif m == 1:

nan_x = 0

nan_y = 0

elif m == 2:

dong_x = 0

dong_y = 0

elif m == 3:

xi_x = 0

xi_y = 0

elif m == 4:

zhong_x = 0

zhong_y = 0

blobs = img.find_blobs(black_threshold, roi=r[0:4],pixels_threshold=100, area_threshold=100, merge=False)

for b in blobs:

#记录大于threshold_pixel值的黑色色块的数量

if b.pixels() > threshold_pixel:

img.draw_rectangle(b.rect())

print(b.pixels())

black_num = black_num + 1;

print(zhong_x,zhong_y)

uart.write(pack_dot_data())

print(black_num)

print(clock.fps())

k210关键代码,全部代码比较多,请下载看(开源)

import sensor, image, lcd, time

import KPU as kpu

import gc, sys

from fpioa_manager import fm

from machine import UART

fm.register(15, fm.fpioa.UART1_TX, force=True)

fm.register(17, fm.fpioa.UART1_RX, force=True)

uart_A = UART(UART.UART1, 115200)

class Dot(object):

x = 0

y = 0

ok = 0

flag = 0

One = 0

Two = 0

Three = 0

Four = 0

Five = 0

Six = 0

Seven = 0

Eight = 0

dot = Dot()

#数据打包#

def pack_dot_data():

pack_data=bytearray([0xAA,0xFF,

dot.One,dot.Two,dot.Three,dot.Four,dot.Five,dot.Six,dot.Seven,dot.Eight,

0xCC])

dot.x = 0

dot.y = 0

dot.One = 0

dot.Two = 0

dot.Three = 0

dot.Four = 0

dot.Five = 0

dot.Six = 0

dot.Seven = 0

dot.Eight = 0

lens = len(pack_data) #数据包大小

#pack_data[3] = lens-6; #有效数据个数

#sc = 0

#ac = 0

#i = 0

#while i<(lens-1):

#sc = sc + pack_data[i]

#ac = ac + sc

#i=i+1

#pack_data[lens-2] = sc

#pack_data[lens-1] = ac;

return pack_data

# #

def lcd_show_except(e):

import uio

err_str = uio.StringIO()

sys.print_exception(e, err_str)

err_str = err_str.getvalue()

img = image.Image(size=(224,224))

img.draw_string(0, 10, err_str, scale=1, color=(0xff,0x00,0x00))

lcd.display(img)

def main(anchors, labels = None, model_addr="/sd/test.kmodel", sensor_window=(224, 224), lcd_rotation=0, sensor_hmirror=False, sensor_vflip=False):

sensor.reset()

sensor.set_pixformat(sensor.RGB565)

sensor.set_framesize(sensor.QVGA)

sensor.set_windowing(sensor_window)

sensor.set_hmirror(1)

sensor.set_vflip(1)

sensor.run(1)

lcd.init(type=1)

lcd.rotation(lcd_rotation)

lcd.clear(lcd.WHITE)

if not labels:

with open('labels.txt','r') as f:

exec(f.read())

if not labels:

print("no labels.txt")

img = image.Image(size=(320, 240))

img.draw_string(90, 110, "no label s.txt", color=(255, 0, 0), scale=2)

lcd.display(img)

return 1

try:

img = image.Image("startup.jpg")

lcd.display(img)

except Exception:

img = image.Image(size=(320, 240))

img.draw_string(90, 110, "loading model...", color=(255, 255, 255), scale=2)

lcd.display(img)

task = kpu.load(model_addr)

kpu.init_yolo2(task, 0.5, 0.3, 5, anchors) # threshold:[0,1], nms_value: [0, 1]

try:

while(True):

img = sensor.snapshot()

t = time.ticks_ms()

objects = kpu.run_yolo2(task, img)

t = time.ticks_ms() - t

if objects:

for obj in objects:

pos = obj.rect()

img.draw_rectangle(pos)

dot.x = pos[0]+(int)(pos[2]/2) #x坐标

dot.y = pos[1]+(int)(pos[3]/2) #y坐标

dot.ok= dot.ok+1

img.draw_cross(dot.x, dot.y)

img.draw_string(pos[0], pos[1], "%s : %.2f" %(labels[obj.classid()], obj.value()), scale=2)

if (labels[obj.classid()] == "1" and obj.value() > 0.70) or dot.One==1:

dot.One = 1

else :

dot.One = 0

if (labels[obj.classid()] == "2" and obj.value() > 0.70) or dot.Two==1:

dot.Two = 1

else :

dot.Two = 0

if (labels[obj.classid()] == "3" and obj.value() > 0.70) or dot.Three==1:

dot.Three = 1

else :

dot.Three = 0

if (labels[obj.classid()] == "4" and obj.value() > 0.70) or dot.Four==1:

dot.Four = 1

else :

dot.Four = 0

if (labels[obj.classid()] == "5" and obj.value() > 0.50) or dot.Five==1:

dot.Five = 1

else :

dot.Five = 0

if (labels[obj.classid()] == "6" and obj.value() > 0.70) or dot.Six==1:

dot.Six = 1

else :

dot.Six = 0

if (labels[obj.classid()] == "7" and obj.value() > 0.70) or dot.Seven==1:

dot.Seven = 1

else :

dot.Seven = 0

if (labels[obj.classid()] == "8" and obj.value() > 0.70) or dot.Eight==1:

dot.Eight = 1

else :

dot.Eight = 0

# print("centre_x = %d, centre_y = %d"%(dot.x, dot.y))

else :

dot.ok = 0

dot.flag = dot.ok

dot.One = 0

dot.Two = 0

dot.Three = 0

dot.Four = 0

dot.Five = 0

dot.Six = 0

dot.Seven = 0

dot.Eight = 0

if dot.ok>10:

dot.flag = 1

uart_A.write(pack_dot_data()) #发送数据

img.draw_string(0, 200, "t:%dms" %(t), scale=2)

lcd.display(img)

except Exception as e:

raise e

finally:

kpu.deinit(task)

if __name__ == "__main__":

try:

labels = ["3", "4", "1", "2", "7", "8", "5", "6"]

anchors = [1.7048, 1.6693, 1.8474, 2.1746, 2.0003, 1.8557, 2.1034, 2.612, 2.4321, 3.0607]

# main(anchors = anchors, labels=labels, model_addr=0x300000, lcd_rotation=0)

main(anchors = anchors, labels=labels, model_addr="/sd/test.kmodel")

except Exception as e:

sys.print_exception(e)

lcd_show_except(e)

finally:

gc.collect()

stm32f407代码不好放,直接下载

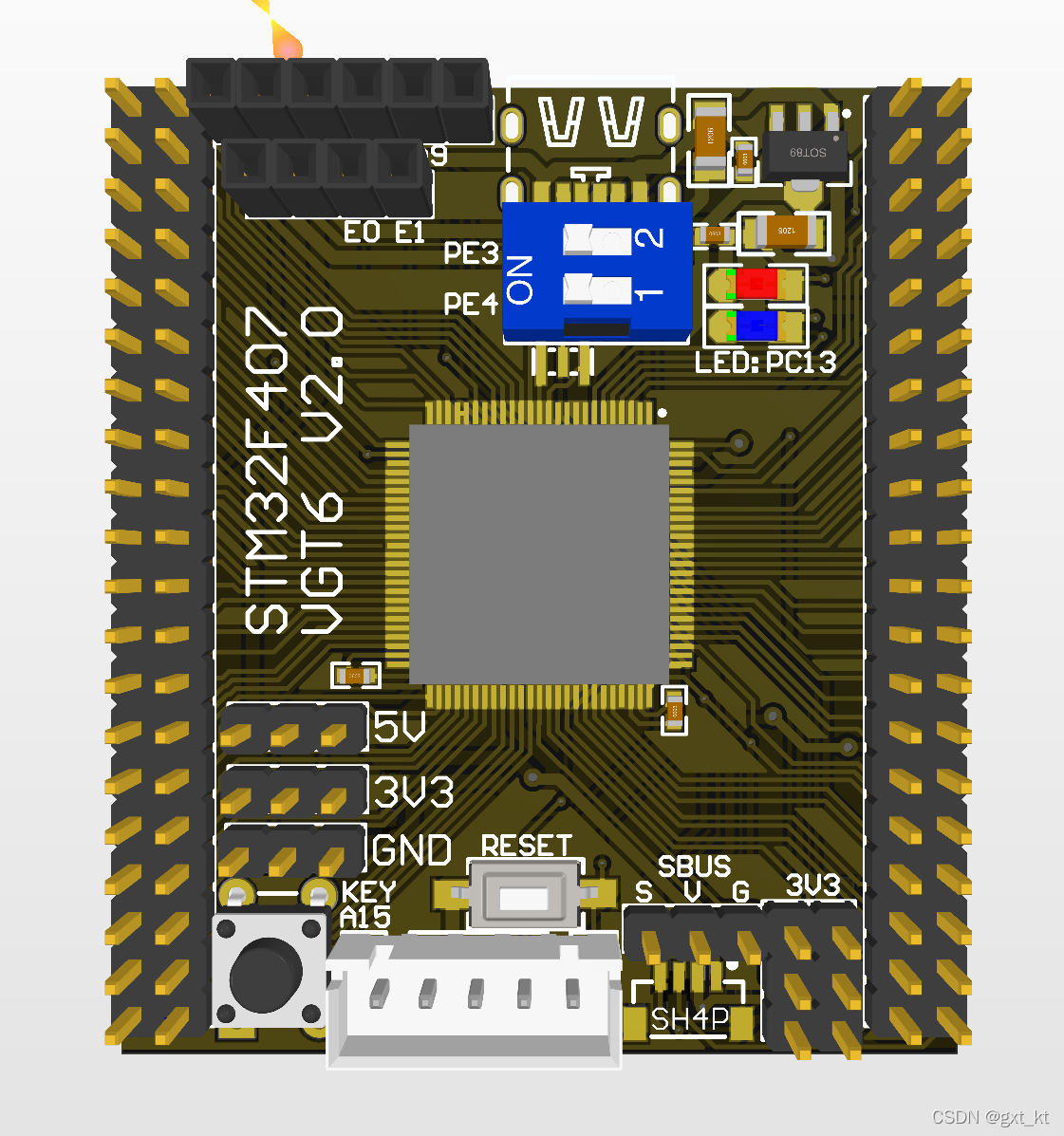

比赛两辆车车上的核心板AD3D图(自己画的)

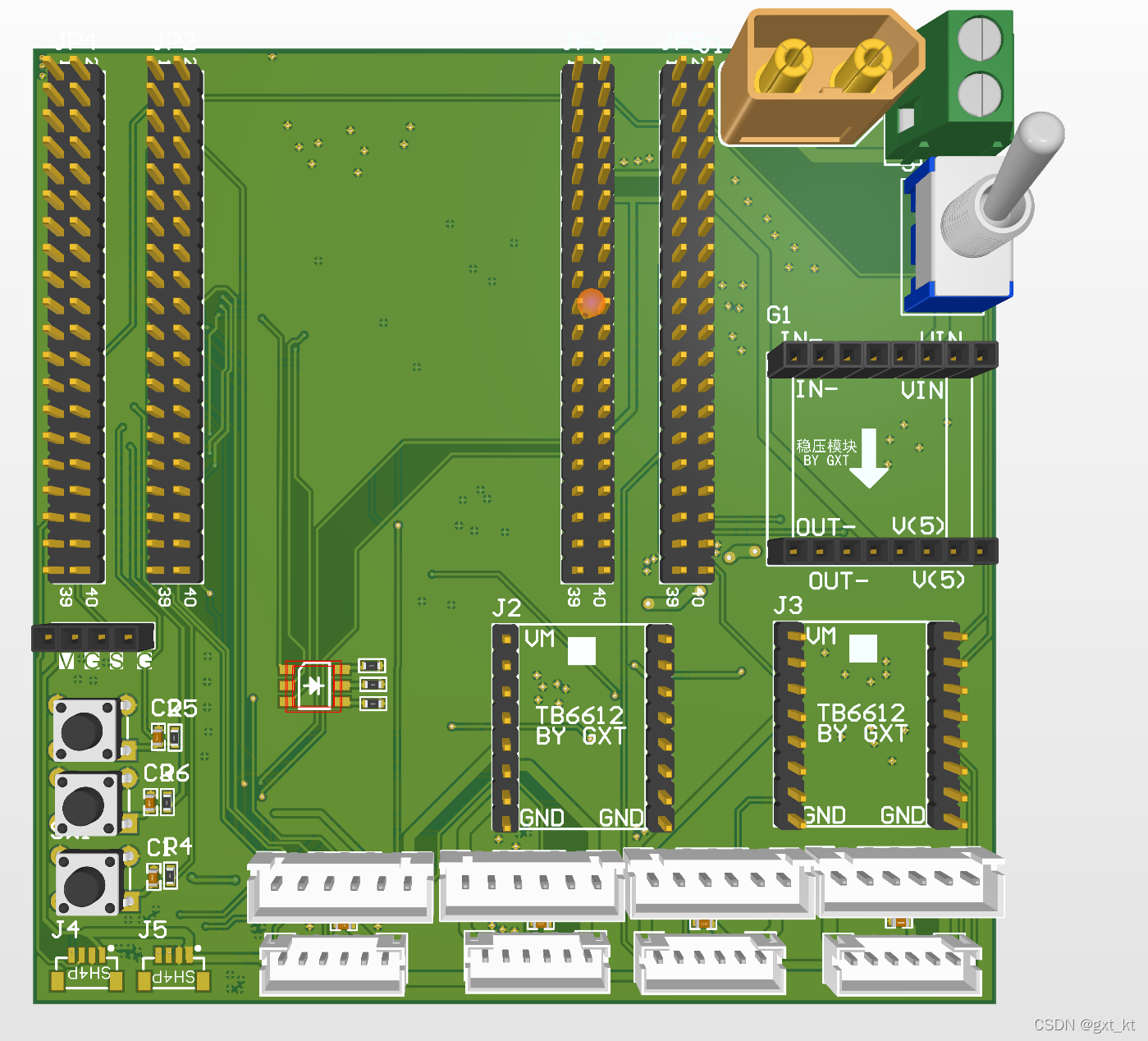

对应上面核心板的底板

智能推荐

分享一个从IEEE Xplore上批量下载会议论文的方法_ieee xplore 脚本-程序员宅基地

文章浏览阅读1.8w次,点赞5次,收藏11次。博客地址标签(空格分隔): IEEE Xplore, bash 测试环境:Ubuntu 15.04, 中山大学首先,从下载一篇论文开始,在IEEE Xplore上任意下载一篇论文,获取下载链接, 如:http://ieeexplore.ieee.org/ielx7/6875427/6877223/06877226.pdf?tp=&arnumber=6877226&isnumber=687722_ieee xplore 脚本

chrome代理插件下载安装_谷歌proxy插件下载-程序员宅基地

文章浏览阅读2.2k次。https://github.com/FelisCatus/SwitchyOmega/releases下载直接将下载的crx文件拖入开发者模式的扩展程序中安装chrome://extensions/若将SwitchyOmega_Chromium.crx拖到chrome里无法安装,可把此文件后缀改为.zip,拖到chrome里即可..._谷歌proxy插件下载

图像处理重点-程序员宅基地

文章浏览阅读243次。第一章 数字图像处理概论* 图像 是对客观存在对象的一种相似性的、生动性的描述或写真。* 模拟图像空间坐标和明暗程度都是连续变化的、计算机无法直接处理的图像* 数字图像空间坐标和灰度均不连续的、 用离散的数字 (一般整数)表示的图像 (计算机能处理)。是图像的数字表示,像素是其最小的单位。* 数字图像处理 (Digital Image Processing )利用计算机对数字图像进行 (..._2. 在实际的图像处理应用中,最主要的图像来源于电磁辐射成像,常见的电磁辐射

BUUCTF Web [NCTF2019]Fake XML cookbook1 & [安洵杯 2019]easy_web1_buuctfweb xml-程序员宅基地

文章浏览阅读585次。BUUCTF Web [NCTF2019]Fake XML cookbook1 & [安洵杯 2019]easy_web1_buuctfweb xml

网页设计与制作实验一HTML基础应用_html文字实验-程序员宅基地

文章浏览阅读2.4k次。通过本次实验,了解HTML文档结构,熟练掌握HTML基本标记及属性,能够运用HTML制作简单的页面。掌握了常用特殊字符标记、到标记的使用、图像的srcwidthheightborder等属性的应用和文本标记和图像标记的混合应用。_html文字实验

编写XML XmlTextWriter与XmlDocument(转)_xmltextwriter 转-程序员宅基地

文章浏览阅读2.3k次。XmlTextWriter类可以把XML写入一个流、文件或TextWriter对象中。简单例子: private void button2_Click(object sender, System.EventArgs e) { string filename = "booknew.xml"; XmlTextWriter tw = new XmlTextWriter(filename,null);

随便推点

python脚本运行gprMax3.0批量仿真GPR数据_gprmax 输出图像为txt-程序员宅基地

文章浏览阅读9.8k次,点赞11次,收藏98次。python脚本运行gprMax3.0批量仿真GPR B-scan图像1.引言2.Python脚本3.可能出现的报错4.数据展示1.引言探地雷达(GPR)结合深度学习通常需要大量的训练数据集,对于GPR仿真数据集的获取,我们一般通过gprMax生成,而gprMax3.0仿真数据时需要通过cmd命令提示符窗口人工一条一条地输入指令(通过cmd命令生成GPR B-scan图像:可以参考我的上一篇博客.),对于批量生成GPR数据非常不方便。因此,有必要写一些Python脚本,实现自动化批量生成GPR数据集。_gprmax 输出图像为txt

机器学习_factor_regression_data/factor_returns.csv-程序员宅基地

文章浏览阅读1.2k次。机器学习算法课程定位、目标定位课程以算法、案例为驱动的学习,伴随浅显易懂的数学知识作为人工智能领域(数据挖掘/机器学习方向)的提升课程,掌握更深更有效的解决问题技能目标应用Scikit-learn实现数据集的特征工程掌握机器学习常见算法原理应用Scikit-learn实现机器学习算法的应用,结合场景解决实际问题机器学习概述了解机器学习定义以及应用场景什么是机器学习1、 背景介..._factor_regression_data/factor_returns.csv

图论-Floyd算法-程序员宅基地

文章浏览阅读129次。/*枚举顶点k范围[1,n] 以k为中介点,枚举所有定点对i和j.i和j的范围[1,n] if(dis[i][k]+dis[k][j]<dis[i][j]) dis[i][j]=dis[i][k]+dis[k][j];*/#include<cstdio>#include<algorithm..._图论loyd

全球芯片行业现状分析:大家都在依赖美国 未来如何破局?-程序员宅基地

文章浏览阅读1.1k次。来源:网易智能翻译:乐邦香港媒体《南华早报》近日发文称,中国依赖于美国的核心技术已有一定的时日,但全世界都是如此,美国在半导体制造领域无可撼动的领先优势,是50多年的研发...

VIVADO中关于管脚约束错误的一种解决方法_set_property severity-程序员宅基地

文章浏览阅读2.4w次,点赞25次,收藏81次。在vivado中,有的IP核已经包含了模块的引脚配置,这样在约束文件中就不用写相应的约束设置。然而在生成位码流的时候就可能会出现如下的错误提示:[DRC UCIO-1] Unconstrained Logical Port: 16 out of 22 logical ports have no user assigned specific location constraint (LOC). T..._set_property severity

pytorch 实现 GRL Gradient Reversal Layer_pytorch grl-程序员宅基地

文章浏览阅读5k次,点赞18次,收藏36次。在GRL中,要实现的目标是:在前向传导的时候,运算结果不变化,在梯度传导的时候,传递给前面的叶子节点的梯度变为原来的相反方向。举个例子最好说明了:import torchfrom torch.autograd import Functionx = torch.tensor([1.,2.,3.],requires_grad=True)y = torch.tensor([4.,5.,6.],requires_grad=True)z = torch.pow(x,2) + torch.pow(_pytorch grl