请多多关注身边这些需要帮助的人,也许我们的一句关心就是他们的希望_关注身边需要帮助的人-程序员宅基地

技术标签: 数据分析

昨天日常睡前刷B站,看到一个很糟心的话题

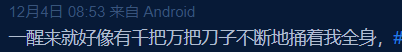

确实,抑郁很不好受。深夜常常一个人翻来覆去睡不着,眼泪不受控制的往下流,仿佛被世界抛弃,又或是突然的情绪爆发……经历很长一段时间后我走出了这个阴影,但是对某些人我可能会愧疚一辈子,我只能默默关注着她发的微博,但是不能去给她任何希望,所以每次看着她这么痛苦都会深深自责

负面情绪完全是她生活的主旋律,然后还看到其他类似的人

所以我就去到处找相关的项目,希望能用我们学的知识去帮助这些需要我们关心的人。

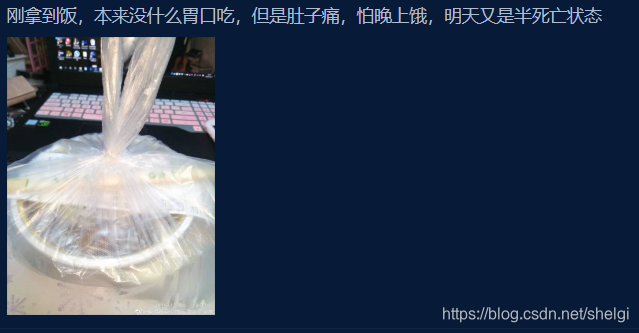

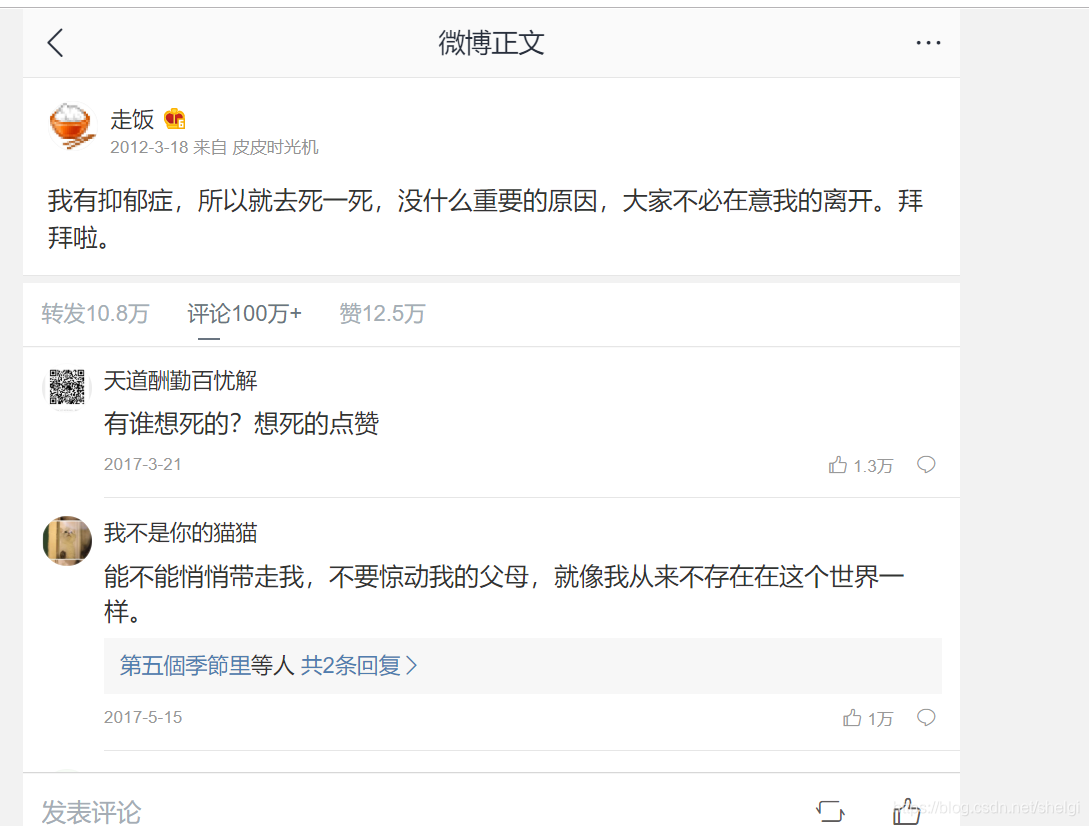

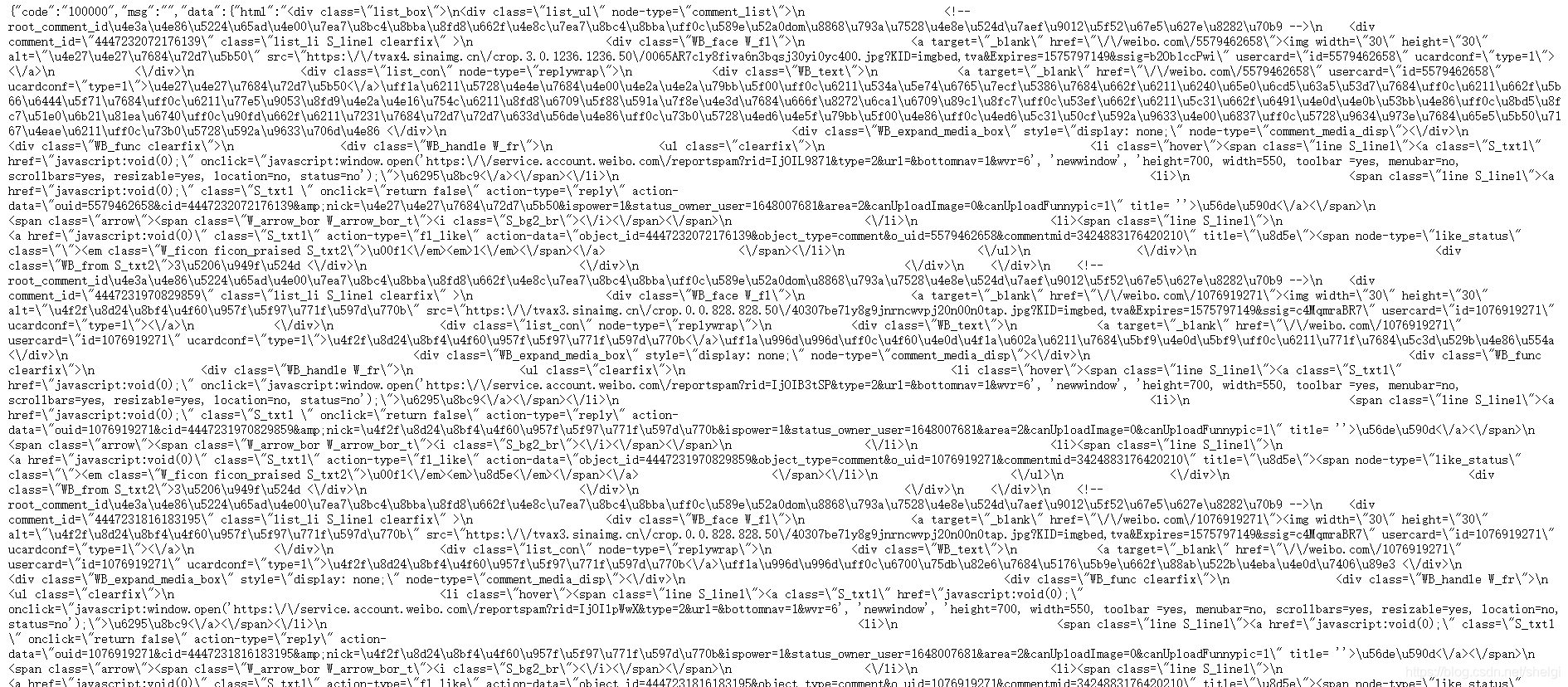

走饭微博的评论网址

去看这下面的评论,可以看到很多这样对生活很不乐观的人,不想让悲剧发生,所以我们要爬取所有评论,设计算法找到那些有放弃自己倾向的人

代码

然后半夜的时候我找了相关的各种链接,然后在一个公众号找到了相关的内容,具体的项目在GitHub,大家可以去这里查看。

具体的代码我也贴在这里

爬虫部分

import json

import requests

import time

import os

from lxml import etree

"""

爬取微博评论

"""

headers = {

'Referer': 'https://weibo.com/1648007681/yark9qWbM?type=comment',

'X-Requested-With': 'XMLHttpRequest',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.97 Safari/537.36',

'Cookie': '填自己的cookie',

}

# 下载图片

def download_pic(url, nick_name):

pic_file_path = os.path.join(os.path.abspath(''), 'pic')

# 当前路径+pic

if not url:

return

if not os.path.exists(pic_file_path):

os.mkdir(pic_file_path)

resp = requests.get(url)

if resp.status_code == 200:

with open(pic_file_path + f'/{nick_name}.jpg', 'wb') as f:

f.write(resp.content)

time.sleep(2)

# 写入留言内容

def write_comment(comment, pic_url, nick_name):

f = open('comment.txt', 'a', encoding='utf-8')

for index, i in enumerate(comment):

if ':' not in i and '回复' not in i and i != '':

# 去除评论的评论

w_comment = "".join(i.split(':')[1:])

print(w_comment)

w_comment = i.strip().replace('\n', '')

# 写入评论

f.write(w_comment.replace('等人', '').replace('图片评论', '')+'\n')

# 获得头像

download_pic(pic_url[index], nick_name[index])

if __name__ == '__main__':

params = {

'ajwvr': 6,

'id': '3424883176420210',

'page': 1,

'_rnd': int(round(time.time() * 1000))

}

URL = 'https://weibo.com/aj/v6/comment/big'

for num in range(1,25,1):

print(f'====== 正在读取第 {num} 页 ========')

params['page'] = num

params['_rnd'] = int(round(time.time() * 1000))

print(params['_rnd'])

resp = requests.get(URL, params=params, headers=headers)

resp = json.loads(resp.text)

if resp['code'] == '100000':

html = resp['data']['html']

html = etree.HTML(html)

data = html.xpath('//div[@node-type="comment_list"]')

for i in data:

# 评论人昵称

nick_name = i.xpath('.//div[@class="WB_text"]/a[1]/text()')

# 评论内容

text = i.xpath('.//div[@class="WB_text"]')

text = [i.xpath('string(.)') for i in text]

# 头像地址

pic_url = i.xpath('.//div[@class="WB_face W_fl"]/a/img/@src')

print(len(nick_name),len(text),len(pic_url))

# 写入文件并下载头像

write_comment([i.strip() for i in text], pic_url, nick_name)

time.sleep(5)

具体实现方法就是去找网页,很简单就可以找到评论的json页

请求再解析网页,得到数据存入txt就行

分析判断部分

import sys

import numpy as np

import segment

from sklearn.model_selection import cross_val_score

from sklearn.metrics import classification_report

from sklearn import metrics

from sklearn.externals import joblib

seg = segment.segment()

print('(1) load texts...')

pos_train_filename = r'data\source\normal.txt'

neg_train_filename = r'data\source\die.txt'

pos_eval_filename = r'data\source\normal_test.txt'

neg_eval_filename = r'data\source\die_test.txt'

origin_pos_train = open(pos_train_filename, encoding='UTF-8').read().split('\n')

origin_neg_train = open(neg_train_filename, encoding='UTF-8').read().split('\n')

origin_pos_eval = open(pos_eval_filename, encoding='UTF-8').read().split('\n')

origin_neg_eval = open(neg_eval_filename, encoding='UTF-8').read().split('\n')

pos_train_dir, pos_train_label_dir = seg.seg_lines_list(1, pos_train_filename)

neg_train_dir, neg_train_label_dir = seg.seg_lines_list(0, neg_train_filename)

pos_test_dir, pos_test_label_dir = seg.seg_lines_list(1, pos_eval_filename)

neg_test_dir, neg_test_label_dir = seg.seg_lines_list(0, neg_eval_filename)

train_pos = open(pos_train_dir, encoding='UTF-8').read().split('\n')

train_neg = open(neg_train_dir, encoding='UTF-8').read().split('\n')

test_pos = open(pos_test_dir, encoding='UTF-8').read().split('\n')

test_neg = open(neg_test_dir, encoding='UTF-8').read().split('\n')

train_pos_label = open(pos_train_label_dir, encoding='UTF-8').read().split('\n')

train_neg_label = open(neg_train_label_dir, encoding='UTF-8').read().split('\n')

test_pos_label = open(pos_test_label_dir, encoding='UTF-8').read().split('\n')

test_neg_label = open(neg_test_label_dir, encoding='UTF-8').read().split('\n')

origin_train_text = origin_pos_train + origin_neg_train

origin_eval_text = origin_pos_eval + origin_neg_eval

train_texts = train_pos + train_neg

test_texts = test_pos + test_neg

train_labels = train_pos_label + train_neg_label

test_labels = test_pos_label + test_neg_label

all_text = train_texts + test_texts

all_labels = train_labels + test_labels

print('(2) doc to var...')

from sklearn.feature_extraction.text import CountVectorizer, TfidfTransformer

# CountVectorizer考虑每种词汇在该训练文本中出现的频率,得到计数矩阵

count_v0= CountVectorizer(analyzer='word',token_pattern='\w{1,}')

counts_all = count_v0.fit_transform(all_text)

count_v1= CountVectorizer(vocabulary=count_v0.vocabulary_)

counts_train = count_v1.fit_transform(train_texts)

print("the shape of train is "+repr(counts_train.shape) )

count_v2 = CountVectorizer(vocabulary=count_v0.vocabulary_)

counts_test = count_v2.fit_transform(test_texts)

print("the shape of test is "+repr(counts_test.shape) )

# 保存数字化后的词典

joblib.dump(count_v0.vocabulary_, "model/die_svm_20191110_vocab.m")

counts_all = count_v2.fit_transform(all_text)

print("the shape of all is "+repr(counts_all.shape))

# 将计数矩阵转换为规格化的tf-idf格式

tfidftransformer = TfidfTransformer()

train_data = tfidftransformer.fit(counts_train).transform(counts_train)

test_data = tfidftransformer.fit(counts_test).transform(counts_test)

all_data = tfidftransformer.fit(counts_all).transform(counts_all)

train_data = counts_train

test_data = counts_test

all_data = counts_all

x_train = train_data

y_train = train_labels

x_test = test_data

y_test = test_labels

print('(3) SVM...')

from sklearn.svm import SVC

# 使用线性核函数的SVM分类器,并启用概率估计(分别显示分到两个类别的概率如:[0.12983359 0.87016641])

svclf = SVC(kernel = 'linear', probability=True)

# 开始训练

svclf.fit(x_train,y_train)

# 保存模型

joblib.dump(svclf, "model/die_svm_20191110.m")

# 测试集进行测试

preds = svclf.predict(x_test)

y_preds = svclf.predict_proba(x_test)

preds = preds.tolist()

for i,pred in enumerate(preds):

# 显示被分错的微博

if int(pred) != int(y_test[i]):

try:

print(origin_eval_text[i], ':', test_texts[i], pred, y_test[i], y_preds[i])

except Exception as e:

print(e)

# 分别查看两个类别的准确率、召回率和F1值

print(classification_report(y_test, preds))

下面是segment.py

import jieba

import jieba.posseg as psg

import os

import math

import re

from utils import files_processing

'''

read() 每次读取整个文件,它通常将读取到底文件内容放到一个字符串变量中,也就是说 .read() 生成文件内容是一个字符串类型。

readline()每只读取文件的一行,通常也是读取到的一行内容放到一个字符串变量中,返回str类型。

readlines()每次按行读取整个文件内容,将读取到的内容放到一个列表中,返回list类型。

'''

class segment():

user_path = 'data/n.txt'

jieba.load_userdict(user_path)

stopwords_path='data/stopwords.txt'

stopwords = []

with open(stopwords_path, "r", encoding='utf8') as f:

lines = f.readlines()

for line in lines:

stopwords.append(line.strip())

def segment_line(self, file_list,segment_out_dir,stopwords=[]):

'''

字词分割,对每行进行字词分割

:param file_list:

:param segment_out_dir:

:param stopwords:

:return:

'''

for i,file in enumerate(file_list):

segment_out_name=os.path.join(segment_out_dir,'segment_{}.txt'.format(i))

segment_file = open(segment_out_name, 'a', encoding='utf8')

with open(file, encoding='utf8') as f:

text = f.readlines()

for sentence in text:

# jieba.cut():参数sentence必须是str(unicode)类型

sentence = list(jieba.cut(sentence))

sentence_segment = []

for word in sentence:

if word not in stopwords:

sentence_segment.append(word)

segment_file.write(" ".join(sentence_segment))

del text

f.close()

segment_file.close()

def segment_lines(self, file_list,segment_out_dir,stopwords=[]):

'''

字词分割,对整个文件内容进行字词分割

:param file_list:

:param segment_out_dir:

:param stopwords:

:return:

'''

for i,file in enumerate(file_list):

segment_out_name=os.path.join(segment_out_dir,str(file.split('\\')[1].split('.')[0])+'_segment.txt')

with open(file, 'r', encoding='utf-8') as f1, open(segment_out_name, 'w', encoding='utf-8') as f2:

for line in f1.readlines():

sentence_segment = []

property = []

document_cut = psg.cut(line.strip())

for x in document_cut:

if x.word not in stopwords:

sentence_segment.append(x.word)

property.append(x.flag)

# result = ' '.join(sentence_segment) + ' ' + ' '.join(property) + '\n'

result = ' '.join(sentence_segment) + '\n'

f2.write(result)

def split_lines_list(self, type, file, stopwords=stopwords):

'''

字词分割,对整个文件内容进行字词分割

:param file:

:param stopwords:

:return:

'''

file_ = open(file, 'r', encoding='utf-8').readlines()

name = str(file.split('\\')[-1].split('.')[0])

segment_out_name=os.path.join('./data/segment',name+'_segment.txt')

label_out_name=os.path.join('./data/segment',name+'_label.txt')

file_segment = open(segment_out_name, 'w', encoding='utf-8')

label = open(label_out_name, 'w', encoding='utf-8')

for index, i in enumerate(file_):

sentence_segment = []

# property = []

p = re.compile('(\\{..)|(\[.*\])|([\uD800-\uDBFF])|([\uDC00-\uDFFF])')

i=p.sub( '', i.strip())

# document_cut = jieba.cut(i.strip(), cut_all=False)

# for x in document_cut:

# if x not in stopwords:

# sentence_segment.append(x)

# property.append(x.flag)

# result = ' '.join(sentence_segment) + ' ' + ' '.join(property) + '\n'

if index < len(file_)-1:

result = ' '.join(i) + '\n'

label.write(str(type) + '\n')

else:

result = ' '.join(i)

label.write(str(type))

file_segment.write(result)

file_segment.close()

label.close()

return segment_out_name, label_out_name

def seg_lines_list(self, type, file, stopwords=stopwords):

'''

字词分割,对整个文件内容进行字词分割

:param file:

:param stopwords:

:return:

'''

file_ = open(file, 'r', encoding='utf-8').readlines()

name = str(file.split('\\')[-1].split('.')[0])

segment_out_name=os.path.join('./data/segment',name+'_segment.txt')

label_out_name=os.path.join('./data/segment',name+'_label.txt')

file_segment = open(segment_out_name, 'w', encoding='utf-8')

label = open(label_out_name, 'w', encoding='utf-8')

for index, i in enumerate(file_):

sentence_segment = []

# property = []

p = re.compile('(/{..)|(\[.*\])|([\uD800-\uDBFF][\uDC00-\uDFFF][\U00010000-\U0010ffff])')

i=p.sub( '', i.strip())

document_cut = jieba.cut(i.strip(), cut_all=False)

for x in document_cut:

if x not in stopwords:

sentence_segment.append(x)

# property.append(x.flag)

# result = ' '.join(sentence_segment) + ' ' + ' '.join(property) + '\n'

if index < len(file_)-1:

result = ' '.join(sentence_segment) + '\n'

label.write(str(type) + '\n')

else:

result = ' '.join(sentence_segment)

label.write(str(type))

file_segment.write(result)

file_segment.close()

label.close()

return segment_out_name, label_out_name

def MergeTxt(filepath,outfile):

k = open(filepath+outfile, 'a+', encoding='utf-8')

for parent, dirnames, filenames in os.walk(filepath):

for filepath in filenames:

txtPath = os.path.join(parent, filepath)

f = open(txtPath, encoding='utf-8')

k.write(f.read()+"\n")

if __name__=='__main__':

# 多线程分词

# jieba.enable_parallel()

# 加载自定义词典

user_path = 'data/n.txt'

jieba.load_userdict(user_path)

stopwords_path='data/stopwords.txt'

stopwords=getStopwords(stopwords_path)

file_dir='data/source/biaozhu'

segment_out_dir='data/segment/biaozhu_property'

file_list=files_processing.get_files_list(file_dir,postfix='*.txt')

segment_lines(file_list, segment_out_dir, stopwords)

# segment_lines(file_list, segment_out_dir)

这部分代码很多,大家还是去GitHub下载吧,就不多贴了。

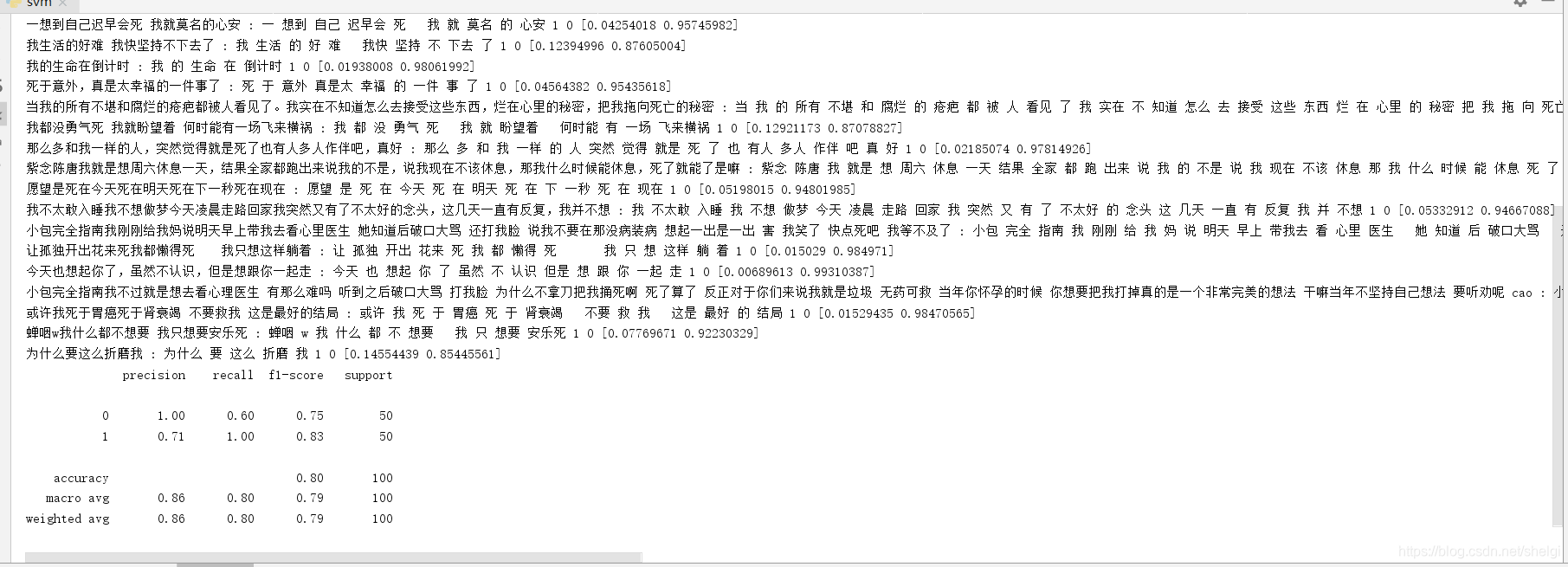

看看运行的结果

虽然有很多负面情绪的评论没有识别出来,但是可以看到准确率还是比较好的

最后

希望大家都去关注一下这个项目,模型主要是svm,后期我想利用现有的数据自己动手写个lstm看看能不能提高分类的准确率。身边需要我们关怀的人很多很多,从亲人,到朋友,最后到陌生人,当他们不顺的时候也许你的一句问候就是他们重新振作的力量。

智能推荐

c# 调用c++ lib静态库_c#调用lib-程序员宅基地

文章浏览阅读2w次,点赞7次,收藏51次。四个步骤1.创建C++ Win32项目动态库dll 2.在Win32项目动态库中添加 外部依赖项 lib头文件和lib库3.导出C接口4.c#调用c++动态库开始你的表演...①创建一个空白的解决方案,在解决方案中添加 Visual C++ , Win32 项目空白解决方案的创建:添加Visual C++ , Win32 项目这......_c#调用lib

deepin/ubuntu安装苹方字体-程序员宅基地

文章浏览阅读4.6k次。苹方字体是苹果系统上的黑体,挺好看的。注重颜值的网站都会使用,例如知乎:font-family: -apple-system, BlinkMacSystemFont, Helvetica Neue, PingFang SC, Microsoft YaHei, Source Han Sans SC, Noto Sans CJK SC, W..._ubuntu pingfang

html表单常见操作汇总_html表单的处理程序有那些-程序员宅基地

文章浏览阅读159次。表单表单概述表单标签表单域按钮控件demo表单标签表单标签基本语法结构<form action="处理数据程序的url地址“ method=”get|post“ name="表单名称”></form><!--action,当提交表单时,向何处发送表单中的数据,地址可以是相对地址也可以是绝对地址--><!--method将表单中的数据传送给服务器处理,get方式直接显示在url地址中,数据可以被缓存,且长度有限制;而post方式数据隐藏传输,_html表单的处理程序有那些

PHP设置谷歌验证器(Google Authenticator)实现操作二步验证_php otp 验证器-程序员宅基地

文章浏览阅读1.2k次。使用说明:开启Google的登陆二步验证(即Google Authenticator服务)后用户登陆时需要输入额外由手机客户端生成的一次性密码。实现Google Authenticator功能需要服务器端和客户端的支持。服务器端负责密钥的生成、验证一次性密码是否正确。客户端记录密钥后生成一次性密码。下载谷歌验证类库文件放到项目合适位置(我这边放在项目Vender下面)https://github.com/PHPGangsta/GoogleAuthenticatorPHP代码示例://引入谷_php otp 验证器

【Python】matplotlib.plot画图横坐标混乱及间隔处理_matplotlib更改横轴间距-程序员宅基地

文章浏览阅读4.3k次,点赞5次,收藏11次。matplotlib.plot画图横坐标混乱及间隔处理_matplotlib更改横轴间距

docker — 容器存储_docker 保存容器-程序员宅基地

文章浏览阅读2.2k次。①Storage driver 处理各镜像层及容器层的处理细节,实现了多层数据的堆叠,为用户 提供了多层数据合并后的统一视图②所有 Storage driver 都使用可堆叠图像层和写时复制(CoW)策略③docker info 命令可查看当系统上的 storage driver主要用于测试目的,不建议用于生成环境。_docker 保存容器

随便推点

网络拓扑结构_网络拓扑csdn-程序员宅基地

文章浏览阅读834次,点赞27次,收藏13次。网络拓扑结构是指计算机网络中各组件(如计算机、服务器、打印机、路由器、交换机等设备)及其连接线路在物理布局或逻辑构型上的排列形式。这种布局不仅描述了设备间的实际物理连接方式,也决定了数据在网络中流动的路径和方式。不同的网络拓扑结构影响着网络的性能、可靠性、可扩展性及管理维护的难易程度。_网络拓扑csdn

JS重写Date函数,兼容IOS系统_date.prototype 将所有 ios-程序员宅基地

文章浏览阅读1.8k次,点赞5次,收藏8次。IOS系统Date的坑要创建一个指定时间的new Date对象时,通常的做法是:new Date("2020-09-21 11:11:00")这行代码在 PC 端和安卓端都是正常的,而在 iOS 端则会提示 Invalid Date 无效日期。在IOS年月日中间的横岗许换成斜杠,也就是new Date("2020/09/21 11:11:00")通常为了兼容IOS的这个坑,需要做一些额外的特殊处理,笔者在开发的时候经常会忘了兼容IOS系统。所以就想试着重写Date函数,一劳永逸,避免每次ne_date.prototype 将所有 ios

如何将EXCEL表导入plsql数据库中-程序员宅基地

文章浏览阅读5.3k次。方法一:用PLSQL Developer工具。 1 在PLSQL Developer的sql window里输入select * from test for update; 2 按F8执行 3 打开锁, 再按一下加号. 鼠标点到第一列的列头,使全列成选中状态,然后粘贴,最后commit提交即可。(前提..._excel导入pl/sql

Git常用命令速查手册-程序员宅基地

文章浏览阅读83次。Git常用命令速查手册1、初始化仓库git init2、将文件添加到仓库git add 文件名 # 将工作区的某个文件添加到暂存区 git add -u # 添加所有被tracked文件中被修改或删除的文件信息到暂存区,不处理untracked的文件git add -A # 添加所有被tracked文件中被修改或删除的文件信息到暂存区,包括untracked的文件...

分享119个ASP.NET源码总有一个是你想要的_千博二手车源码v2023 build 1120-程序员宅基地

文章浏览阅读202次。分享119个ASP.NET源码总有一个是你想要的_千博二手车源码v2023 build 1120

【C++缺省函数】 空类默认产生的6个类成员函数_空类默认产生哪些类成员函数-程序员宅基地

文章浏览阅读1.8k次。版权声明:转载请注明出处 http://blog.csdn.net/irean_lau。目录(?)[+]1、缺省构造函数。2、缺省拷贝构造函数。3、 缺省析构函数。4、缺省赋值运算符。5、缺省取址运算符。6、 缺省取址运算符 const。[cpp] view plain copy_空类默认产生哪些类成员函数