”RDD“ 的搜索结果

首先,RDD是弹性的,可以在内存中缓存数据,并支持容错性。此外,RDD是不可变的,每次对RDD的转换操作都会生成一个新的RDD。最后,RDD采用了延迟计算的策略,只有在需要获取结果时才会进行计算。综上所述,RDD是...

RDD 因果推理复制分配1

spark提出的数据抽象模式RDD弹性分布式数据集

今天面试一个大数据开发工程师,spark相关的知识感觉都能懂一点,但是连基础的RDD稍微一问深一点就不知所云,这种情况基本上是无法通过面试的,今天想用通俗的话把RDD说明白。弹性分布式数据集)是Spark中最基本的...

大数据spark学习之rdd概述

标签: rdd

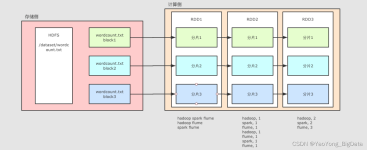

RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。在 Spark 中,对数据的所有操作不外乎创建 RDD、转化已有RDD 以及...

Spark 的核心是建立在统一的抽象弹性分布式数据集(Resiliennt Distributed Datasets,RDD)之上的,这使得 Spark 的各个组件可以无缝地进行集成,能够在同一个应用程序中完成大数据处理。本节将对 RDD 的基本概念及...

RDD编程初级实践数据集

标签: spark

免费下载

中提供了该项目中所有PySpark RDD,DataFrame和SQL示例的说明,所有这些示例均以Python语言编码并在我们的开发环境中进行了测试。目录(Python中的火花示例)PySpark基本示例PySpark –功能PySpark –这是什么? &...

上一章讲了Spark提交作业的过程,这一章我们要讲RDD。简单的讲,RDD就是Spark的input,知道input是啥吧,就是输入的数据。RDD的全名是ResilientDistributedDataset,意思是容错的分布式数据集,每一个RDD都会有5个...

RDD-提取器 该项目是从 RDF 数据集中提取 RDD(RDF 数据描述)。 有关 RDD 的更多信息,请访问: ://dbis.informatik.uni-freiburg.de/forschung/projekte/rdd/ 在那里您还可以找到 SP2bench 工具来生成与 RDD-...

hbase-rdd:Spark RDD从HBase读取,写入和删除

RDD是什么? RDD是Spark中的抽象数据结构类型,任何数据在Spark中都被表示为RDD。从编程的角度来看,RDD可以简单看成是一个数组。和普通数组的区别是,RDD中的数据是分区存储的,这样不同分区的数据就可以分布在...

RDD RDD因果推论包含汉森复制

这是一个Apache Spark的演讲ppt,全都是英文的,制作时间是2020年的。包含Spart的最近状态,RDD和其生态。my presentation on RDD & Spark.pptx

1.1什么是RDD(1)RDD(ResilientDistributedDataset)弹性分布式数据集,它是Spark的基本数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。(2)具有数据流模型的特点:自动容错、位置感知性调度、可...

弹性分布式数据集(RDD)是一组不可变的JVM对象的分布集,可以用于执行高速运算,它是Apache Spark的核心。 在pyspark中获取和处理RDD数据集的方法如下: 1. 首先是导入库和环境配置(本测试在linux的pycharm上完成...

背景 本文使用idea编程 spark版本 <scala.version>2.11.8</scala.version> <spark.version>2.2.0<...Spark中,只有遇到action,才会执行RDD的计算(即延迟计算)</ps> ...

博客主页:https://manor.blog.csdn.net欢迎点赞 收藏 ⭐留言 如有错误敬请指正! 本文由 Maynor 原创,首发于 程序员宅基地 感觉这辈子,最深情绵长的注视,都给了手机⭐ 专栏持续更新,欢迎订阅:...

Spark-RDD编程基础,RDD的创建、RDD转换操作、Spark对于WordCount问题的实现

spark rdd函数大全。spark rdd操作为core操作,虽然后续版本主要以dataset来操作,但是rdd操作也是不可忽略的一部分。

本文由 Maynor 原创,首发于 程序员宅基地。...分区内元素glom().collect()PySpark中RDD的创建两种方式。扩展阅读:RDD分区数如何确定。WordCount中RDD。RDD特点—不需要记忆。通过外部数据创建RDD。并行化方式创建RDD。

大数据实验报告Windows环境下安装Spark及RDD编程和Spark编程实现wordcount.doc

键值对RDD常用的键值对RDD转换操作

推荐文章

- Unity3D 导入资源_unity怎么导入压缩包-程序员宅基地

- jqgrid 服务器端验证,javascript – jqgrid服务器端错误消息/验证处理-程序员宅基地

- 白山头讲PV: 用calibre进行layout之间的比对-程序员宅基地

- java exit方法_Java:如何测试调用System.exit()的方法?-程序员宅基地

- 如何在金山云上部署高可用Oracle数据库服务_rman target sys/holyp#ssw0rd2024@gdcamspri auxilia-程序员宅基地

- Spring整合Activemq-程序员宅基地

- 语义分割入门的总结-程序员宅基地

- SpringBoot实践(三十五):JVM信息分析_怎样查看springboot项目的jvm状态-程序员宅基地

- 基于springboot+vue的戒毒所人员管理系统 毕业设计-附源码251514_戒毒所管理系统-程序员宅基地

- 【LeetCode】面试题57 - II. 和为s的连续正数序列_leet code 和为s的正数序列 java-程序员宅基地