”TVM深度学习编译器“ 的搜索结果

以tvm.graph_runtime.create为例 宏展开 #define TVM_REGISTER_GLOBAL(OpName) TVM_STR_CONCAT(TVM_FUNC_REG_VAR_DEF, __COUNTER__) = ::tvm::runtime::Registry::Register(OpName) 扩展到: TVM_STR_CONCAT...

陈天奇博士的tvm项目是一个非常优秀的开源项目,它是一种深度学习编译器框架,旨在为各种硬件平台提供高效的深度学习推理。TVM利用深度学习模型的局部性和稀疏性等特点,通过优化编译的方式实现高效的硬件加速。 ...

tvm relay inline pass的调研 relay的流程;pass功能;cpu上跑通单元测例 tests/python/relay/test_pass_inline.py, 明确pass原理; 能否使用inline针对一个网络生成一个call func ,这种方式能很好支持当前bangc...

点击上方“小白学视觉”,选择加"星标"或“置顶”重磅干货,第一时间送达目前,国内有多个深度学习框架开源,OneFlow也在为开源做最后的准备,2020是深度学习框架领域非常热闹的一年。一个...

机器之心专栏作者:Lin Yuan当前,各式各样深度学习框架的发展充分赋能机器学习,尤其是深度学习领域,为开发者提供了极致便利。在本文中,Waymo 软件工程师 Lin Yuan 细数了二...

深度学习编译中间件之NNVM(十二)NNVM源代码阅读1 深度学习编译中间件之NNVM(十三)NNVM源代码阅读2 NNVM Core Tensor Operators官方文档 参考文档1从最外层的nnvm.compiler.build函数入手逐渐深入到NNVM的实现细节...

深度学习编译中间件之NNVM(十二)NNVM源代码阅读1 深度学习编译中间件之NNVM(十三)NNVM源代码阅读2 深度学习编译中间件之NNVM(十四)NNVM源代码阅读3 深度学习编译中间件之NNVM(十五)NNVM源代码阅读4 深度学习编译...

TVM论文阅读1 介绍1.1 优化的基本挑战1.2 TVM:一个端到端优化堆栈2 优化计算图2.1 计算图2.2 操作符融合2.3 数据布局转换2.4 计算图级别优化的限制3 优化张量操作3.1 Tensor表达式语言3.2 调度空间3.3 协作式嵌套...

深度学习编译中间件之NNVM(十二)NNVM源代码阅读1 深度学习编译中间件之NNVM(十三)NNVM源代码阅读2 深度学习编译中间件之NNVM(十四)NNVM源代码阅读3 深度学习编译中间件之NNVM(十五)NNVM源代码阅读4 NNVM Compiler...

2016 年,第一颗基于可重构计算的人工智能芯片诞生于清华。该成果曾发表在《IEEE 固态电路期刊》,《麻省理工科技评论》也报道过该芯片。 这是清华可重构计算实验室 “十年磨一剑” 的成果。...

深度学习编译器TVM的ubuntu安装步骤

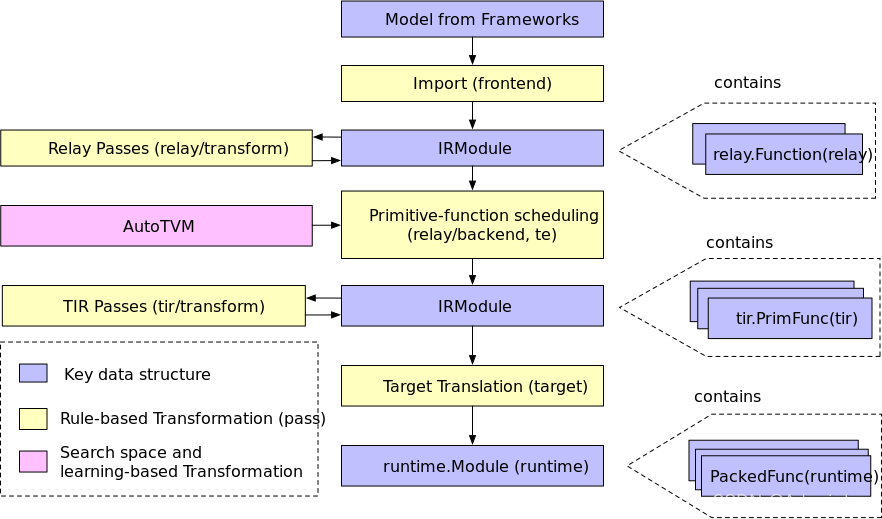

TVM 可以将模型编译成可链接的对象模块,然后可以用轻量级的 TVM 运行时来运行,该运行时提供 C 语言的 API 来动态加载模型,以及其他语言的入口,如 Python 和 Rust。为了帮助将 Relay 表示转换为 TE 表示的过程,...

原文链接:... 前言 亲,显存炸了,你的显卡快冒烟了! torch.FatalError: cuda runtime error (2) : out of memory at /opt/conda/conda-bld/pytorch_1524590031827/work/aten/src...

深度学习编译中间件之NNVM(十二)NNVM源代码阅读1 深度学习编译中间件之NNVM(十三)NNVM源代码阅读2 深度学习编译中间件之NNVM(十四)NNVM源代码阅读3 NNVM Frontend组件主要负责将多种深度学习框架训练出来的模型...

详解三大编译器: gcc、llvm 和 clang (icc/icpc/ifort)

对于 AI 开发人员来说,在各种硬件平台上优化深度神经网络的性能仍然是一个难题。在系统支持方面,我们面临着一个多对多的问题:将多个前端(例如 Tensorflow、ONNX、MXNet)的训练模型部署到多个硬件平台(例如 CPU...

近几年,随着神经网络(Neural Networks)在图像识别领域的不断突破,很多研究人员将目光投向了深度学习(Deep Learning)的应用。深度学习技术通过堆叠多层神经网络模型来自动学习到图像数据的高级特征表示,并据此...

推荐文章

- 微信公众号网页静默授权/非静默授权(uniapp版)_微信公众号静默授权-程序员宅基地

- A Key Volume Mining Deep Framework for Action Recognition-程序员宅基地

- python创建窗体_python生成窗口-程序员宅基地

- PowerDesigner16 时序图_使用powerdesiger 画出时序图有接口 控制-程序员宅基地

- Doris系列17-动态分区_dynamic_partition.history_partition_num-程序员宅基地

- Linux命令_禅道的运行日志放在哪-程序员宅基地

- Web实训项目--网页设计(附源码)_web前端网页设计代码-程序员宅基地

- Matlab:非负 ODE 解_matlab銝要onnegative-程序员宅基地

- 关于g2o_viewer data/result_after.g2o使用过程中coredump、与lsd_slam依赖包libg2o冲突问题_libg2o_-程序员宅基地

- 学习通选修刷课使用过程(懂得都懂)_学习通脚本-程序员宅基地