一、Transformer博客推荐 Transformer源于谷歌公司2017年发表的文章Attention is all you need,Jay Alammar在博客上对文章做了很好的总结: 英文版:The Illustrated Transformer CSDN上又博主(于建民)对其进行了...

”Transformer“ 的搜索结果

基于 Transformer 的锂电池寿命预测(Remaining Useful Life,RUL)(Python完整源码和数据) Packages pytorch 1.8.0 pandas 0.24.2 基于 Pytorch 的 Transformer 锂电池寿命预测(Remaining Useful Life,RUL)

Transformer在Goole的一篇论文被提出,为了方便实现调用TransformerGoogle还开源了一个第三方库,基于TensorFlow的,一个NLP的社区研究者贡献了一个Torch版本的支持:。这里,我想用一些方便理解的方式来一步一步...

当涉及到自然语言处理(NLP)、Transformer和YOLO技术的实际应用时,有很多不同的示例。以下是一些典型的应用: 自然语言处理(NLP)的应用: 1.机器翻译:NLP技术用于自动将一种语言翻译成另一种语言,例如Google...

Transformer介绍讲义pdf

基于Transformer模型构建的聊天机器人python实现源码+项目说明.zip基于Transformer模型构建的聊天机器人python实现源码+项目说明.zip 该资源内项目源码是个人的毕设,代码都测试ok,都是运行成功后才上传资源,答辩...

transformer_news:基于transformer的中英文平行语料翻译系统

安装模块安装npm install class-transformer-validator --save (或简称): npm i -S class-transformer-validator 对等依赖这个软件包只是一个简单的插件/包装器,因此您也必须安装所需的模块,因为没有它们就无法...

transformer 用于语义分割 内有使用说明 有问题私信 主要是将TransUnet的网络模型拿出来,自己写了加载数据集的方法,使用方便

使用的数据集共有5种类别,使用Swin-T预训练模型进行训练。

VIT(vision transformer)实现图像分类,是将transformer首次应用于CV(计算机视觉)领域,该资源包含所有源代码,拿走技能运行跑通,包含数据集和训练好的权重,分类精度高达99%以上。

Swin-Transformer+gradcam可视化代码+Windows环境

$ pip install tab-transformer-pytorch 用法 import torch from tab_transformer_pytorch import TabTransformer cont_mean_std = torch . randn ( 10 , 2 ) model = TabTransformer ( categories = ( 10 , 5 , 6...

ts-transformer-keys TypeScript自定义转换器,可以获取给定类型的键。 要求 打字稿> = 2.4.1 如何使用此套件 该软件包导出2个函数。 一个是keys ,其在打字稿码用于获得给定类型的键,而另一个是用于编译一个打字...

pytorch实现seq2seq和transformer字符级中英机器翻译,里面有一个小型中英的平行语料数据集和训练好的seq2seq的模型,transformer的模型需要自己训练

我们介绍了一种新颖的方法,该方法可以可视化基于Transformer的模型针对视觉和NLP任务进行的分类。我们的方法还可以可视化每个班级的解释。 方法包括三个阶段:使用我们新颖的LRP公式计算每个关注矩阵的相关性。每个...

审校:百度NLP、龙心尘 翻译:张驰、毅航、Conrad 原作者:Jay Alammar 原链接:https://jalammar.github.io/illustrated-transformer/ 编者按:前一段时间谷歌推出的BERT模型在11项NLP...谷歌的Transformer模型...

PVT transformer pytorch代码

tranformer,self-attention,multi-attention

基于图注意力机制和Transformer的异常检测.docx

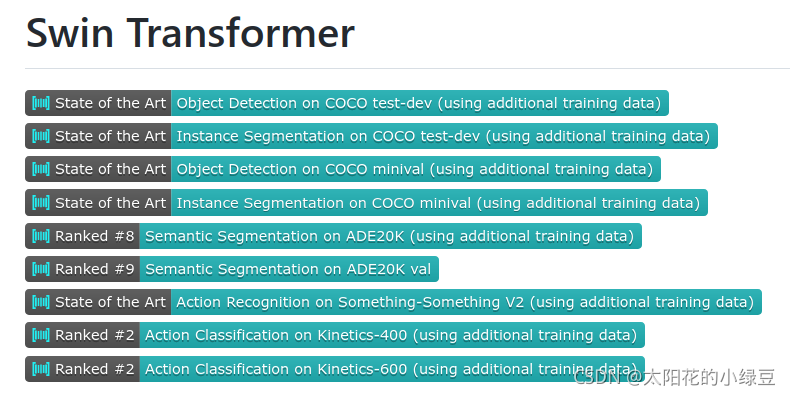

Swin-Transformer图像分类实战,详见文章:https://blog.csdn.net/hhhhhhhhhhwwwwwwwwww/article/details/121744503?spm=1001.2014.3001.5501

VectorNet 是清华MARS Lab和Google Waymo联合在CVPR2020提出的一个基于Transformer的轨迹预测模型。在比较丰富和均衡的自动驾驶数据集上进行实际应用,效果还是相当优异的。

综合分析了现有的主流的nlp翻译模型的即基于CNN的可并行对其文本翻译和基于RNN的LSTM门控长短期记忆时序翻译模型,总结了两个模型的优缺点并在此基础上提出了基于自注意力机制的翻译模型transformer,transformer...

视觉变形金刚 近期基于Transformer的CV作品的纸质清单。 如果您发现一些被忽略的论文,请打开问题或提出要求。 **最后更新时间:2021/04/19更新日志2021 / April-更新了Transformer-in-Vision的所有最新论文。民意...

推荐文章

- 联邦学习综述-程序员宅基地

- virtuoso--工艺库答疑_tsmc mac-程序员宅基地

- C++中的exit函数_c++ exit-程序员宅基地

- Java入门基础知识点总结(详细篇)_java基础知识重点总结-程序员宅基地

- 【SpringBoot】82、SpringBoot集成Quartz实现动态管理定时任务_springboot集成quratz 实现动态任务调度-程序员宅基地

- testNG常见测试方法_idea_java_testng 测试-程序员宅基地

- Debian11系统安装-程序员宅基地

- Centos7重置root用户密码_centos7更改root密码-程序员宅基地

- STM32常用协议之IIC协议详解_正点原子stm32 iic-程序员宅基地

- 【视频播放】Jplayer视频播放器的使用_jplayer 播放amr-程序员宅基地