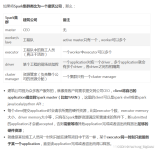

#YARN的任务提交流程简述及图解 1,Client向ResourceManager发出请求,提交程序,(ResourceManager中有Scheduler调度器和ApplicationsManager应用程序管理器 2,ResourceManager向Scheduler返回一个ApplicationID...

”YARN任务提交流程简述及图解“ 的搜索结果

java提交spark任务到yarn平台的配置讲解共9页.pdf.zip

YARN任务执行流程yarn简述关键字解释作业提交运行情况 yarn简述 yarn是一个资源调度平台,负责为运算程序提供服务器运算资源,相当于一个分布式操作系统平台,而mapreduce等运算程序则相当于运行与操作系统之上的...

HDFS(Hadoop Distributed ...HDFS 是的主要组件之一,其他组件包括MapReduce和 YARN。HDFS的使用场景:适合一次写入,多次读出的场景。一个文件经过创建、写入和关闭之后就不需要改变。MapReduce是一种分布式计算框架。

YARN:实现分布式资源管理和 任务调度 资源管理:将多台机器的资源进行整合,构建成一个整体 整个集群中所有资源的分配 运行这个程序分配多少资源给它运行 任务调度:提交运行一个分布式程序,利用分布式的资源...

java提交spark任务到yarn平台的配置讲解共9页.pdf.zip

首先放张YARN官网的图便于理解: 讲一下YARN的优点(网上一搜一箩筐): 首先要提一下MapReduce1,它只包含JobTracker(协调在集群上运行的所有作业)和TaskTracker(运行分配的任务并定期向 JobTracker 报告...

1)MrAppMaster:负责整个程序的过程调度及状态协调 2)MapTask:负责map阶段的整个数据处理流程 3)ReduceTask:负责reduce阶段的整个数据处理流程 工作全流程详解: 上面图一和图二中的流程是整个MapReduce最全...

Hadoop是最基础和场景的开源分布式计算平台,ShowMeAI在本节内容中给大家讲解Hadoop相关知识。

YARN基础架构1.1ResourceManager主要作用1.2NodeManager主要作用1.3ApplicationMaster主要作用1.4 Container主要作用2.YARN的工作机制 1. YARN基础架构 YARN主要由ResourceManager、NodeManager、ApplicationMaster...

【大数据入门笔记系列】第六节 ...第一阶段各个节点独立完成所分得的计算任务,这个时候各节点保持着并发运行,这便是Map阶段; 第二阶段就是统计第一阶段的结果,统计实例根据统计内容可以为多个(有些统计只能有一...

Spark 的运行流程 1、Spark 的基本运行流程 1、构建 DAG 使用算子操作 RDD 进行各种 transformation 操作,最后通过 action 操作触发 Spark 作业运行。 提交之后 Spark 会根据转换过程所产生的 RDD 之间...

Mapreduce的编程流程主要分八个阶段:两个MAP阶段,四个shuffle阶段,两个reduce阶段。 Map两个阶段: 1:设置inputformat类,将数据分为key-value对(k1 v1),并将其输入到第二步。 2:自定义Map逻辑将第一步的结果...

部署集群的原因 如果我们采用单点的伪分布式部署,那么NN节点挂了,就不能对外提供服务。集群的话,存在两个NN节点,一个挂了,另外一个从standby模式直接切换到active状态,实时对外提供服务(读写)。...

看到github上一篇超炫的博文,是阿里工程师总结的《后端架构师技术图谱》,分享给大家。\ 数据结构 队列 集合 链表、数组 字典、关联数组 栈 树 二叉树 完全二叉树 平衡二叉树 ... ...

阅读文本大概需要3分钟。SOA和RPC随着互联网规模发展,面向服务的体系架构(SOA)成为主流的架构方式,SOA的本质思想是高内聚、低耦合地实现分治,各个系统之间通过服务...

Spark环境搭建教程

标签: spark

Spark环境搭建 Spark Local本地模式 Standalone-独立集群 Standalone-HA Spark-On-Yarn Spark 是一种基于内存的快速、通用、可扩展的大数据分析计算引擎

引言:随着大数据技术的发展,实时流计算、机器学习、图计算等领域成为较热的研究方向,而Spark...本文选自《图解Spark:核心技术与案例实战》。 Spark 生态系统以Spark Core 为核心,能够读取传统文件(如文本...

推荐文章

- type-c转type A 3.0线以及otg线序_typec线序-程序员宅基地

- 软件测试周刊(第13期):质量是一种认知_conan流量回放-程序员宅基地

- python opencv图像对比度增强,用python(cv2)中的OpenCV增加彩色图像对比度的最快方法是什么?...-程序员宅基地

- [IDEA] chapter_reader - idea看小说阅读插件 - idea摸鱼插件_idea看小说插件-程序员宅基地

- 自学编程需要注意什么?_自学编程哪些注意-程序员宅基地

- 21.等值线图(Counter Plot)、Contour Demo、Creating a “meshgrid”、Calculation of the Values、等_counter图-程序员宅基地

- Vue刷新当前页面并带参_vue刷新页面并传递参数-程序员宅基地

- pktgen:DPDK流量生成器_pktgen-dpdk:22.04.1-程序员宅基地

- 判断URL中是否包含中文汉字_检测url中是否有中文-程序员宅基地

- hyperledger composer之查询语言_composer access control language-程序员宅基地