Spark用scala语言实现了RDD的API,程序开发者可以通过调用API对RDD进行操作处理。 下图为RDD的处理过程: RDD经过一些列的“转换”操作,每一次转换都会产生不同的RDD,以供给下一次“转换”操作使用,直到...

”rdd“ 的搜索结果

如何将RDD [Row]转换为RDD [String](How to convert RDD[Row] to RDD[String])我有一个名为source的DataFrame,一个来自mysql的表val source = sqlContext.read.jdbc(jdbcUrl, "source", connectionProperties)我已...

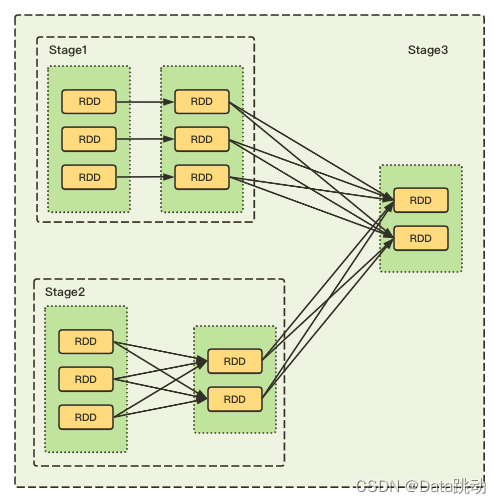

看完秒懂RDD中的stage划分

spark基本RDD方法(Java版)一:Transformationsmap:输入和输出条数一致;JavaRDD mappedRDD = lines.map(s -> s.length());filter:只保留返回true的数据;JavaRDD mappedRDD = lines.filter(new Function() {@...

2.Key-Value型的RDD还拥有Partitioner(分区器),用于决定数据被存储在哪个分区中,目前Spark中支持HashPartitioner(按照哈希分区)和RangeParationer(按照范围进行分区);1.一个RDD由一个或者多个分区(Partitions)...

一、创建RDD 1.由外部存储系统的数据集创建,由外部存储系统的数据集创建,包括本地的文件系统,还有所有Hadoop支持的数据集,比如HDFS、Cassandra、HBase等 val rdd1 = sc.textFile("hdfs://node01:8020/...

Spark 读取CSV文件为RDD 1 准备数据 在开始之前,假设我们在文件夹“c:/tmp/files”中有以下带有逗号分隔文件内容的 CSV 文件名,我使用这些文件来演示示例。 Before we start, let’s assume we have the ...

结合代码详细描述RDD算子的执行流程,并配上执行流程图

作用:返回一个新的RDD,该RDD由每一个输入元素经过func函数转换后组成 需求:创建一个1-10数组的RDD,将所有元素2形成新的RDD (1)创建 scala> var source = sc.parallelize(1 to 10) source: org.apache.spark...

Apache Spark RDD相关知识面试题

RDD(Resilient Distributed Dataset)弹性分布式数据集,是Spark中最基本的数据抽象,代表一个不可变、可分区、里面的元素可并行计算的集合。它用于囊括所有内存中和磁盘中的分布式数据实体。RDD与数组的对比:对比...

RDD弹性分布式数据集(Resilient Distributed Dataset)每个 RDD 都被分为多个分区,这些分区运行在集群中的不同节点上。RDD 支 持 两 种 类 型 的 操 作: 转 化 操 作(transformation) 和 行 动 操 作(action)...

RDD和DataFrame为Spark中经常用到的两个数据结构,对于两个数据结构的比较,简而言之,Dataframe比RDD的速度快,对于结构化的数据,使用DataFrame编写的代码更简洁,因为DataFrame本身对应的就是一个表结构。...

RDD概念 RDD的内部属性 一组分片(Partition),即数据集的基本组成单位 计算每个分片的函数 RDD之间的依赖关系 一个Partitioner,即RDD的分片函数 分区列表,存储存取每个Partition的优先位置(preferred location...

Spark期末复习(二)RDD

标签: spark

【代码】道路病害检测数据集RDD2022的标签映射关系【参考自官网给出的label_map.pbtxt文件,附查看代码】

1.RDD转换RDD的所有转换操作都不会进行真正的计算1.1单个RDD转换操作# 创建测试RDDval rdd = sc.parallelize(Array("hello world","java","scala easy"))# 1.map():遍历RDD中的每个元素,将返回值构成新的RDD,...

RDD的创建 进行Spark核心编程时,首先要做的第一件事,就是创建一个初始的RDD。该RDD中,通常就代表和包含了Spark应用程序的输入源数据。然后在创建了初始的RDD之后,才可以通过Spark Core提供的transformation算子...

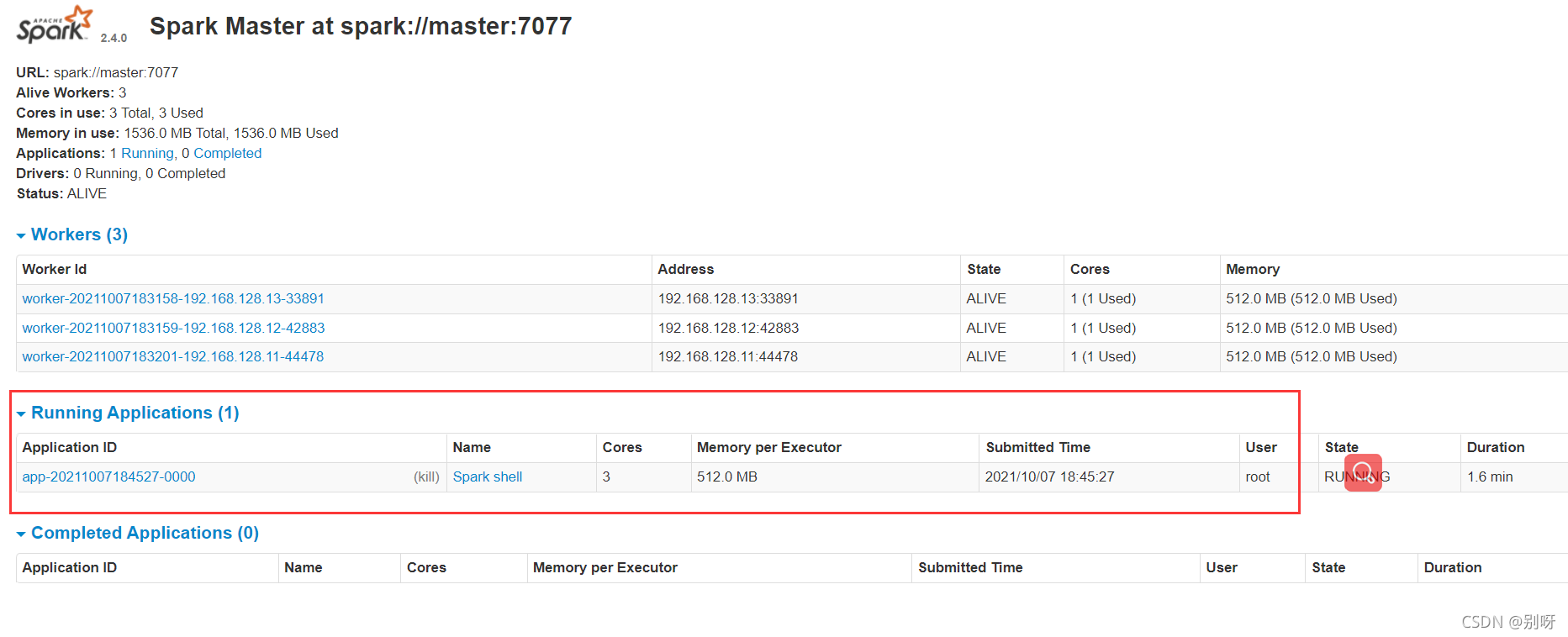

RDD编程初级实践一、spark-shell交互式编程1.该系总共有多少学生2.该系共开设了多少门课程3.Tom同学的总成绩平均分是多少4.求每名同学的选修的课程门数5.该系DataBase课程共有多少人选修6.各门课程的平均分是多少7....

推荐文章

- Android 编译so文件 MP4V2_android下编译mp4v2-程序员宅基地

- 通讯录Contact_02_contact文件内容-程序员宅基地

- Qt笔记(四十二)之QZXing的编译 配置 使用_qzxingfilterrunnable error:-程序员宅基地

- 关于画图软件Dia打开程序始终为英文界面的问题-程序员宅基地

- OpenCV从入门到精通实战(二)——文档OCR识别(tesseract)-程序员宅基地

- 详解avcodec_receive_packet 11_avcodec_receive_packet eagain-程序员宅基地

- OpenGL SuperBible 7th源码编译记录_superbible7-media github-程序员宅基地

- Wireshark简单使用-程序员宅基地

- MXNet 粗糙的使用指南_iou loss mxnet-程序员宅基地

- iOS对ipa包进行代码混淆《二》 ---代码混淆_ipa包混淆-程序员宅基地