我们以flink中自带的wordcount例子作为提交任务,查看在客户端Flink提交任务的详细源码步骤。 入口分析 首先我们看一下提交命令如下: bin/flink run examples/batch/WordCount.jar 接着会在bin/flink shell脚本中...

”任务提交“ 的搜索结果

版权声明:本文为博主原创文章,未经博主允许不得转载!! 欢迎访问:... 交流QQ: 824203453 ...hadoop版本: 2.8.0 spark 版本: 2.2.0 ...1.运行spark on yarn 任务简介 ...yarn集群运行spark任务有两种模...

spark-submit 可以提交任务到 spark 集群执行,也可以提交到 hadoop 的 yarn 集群执行。 1. 例子 一个最简单的例子,部署 spark standalone 模式后,提交到本地执行。 ./bin/spark-submit \ --master spark://...

flink提交参数详细说明

标签: flink

flink 任务提交

19/07/20 18:06:06 INFO yarn.Client: client token: N/A diagnostics: N/A ApplicationMaster host: BG001 ApplicationMaster RPC port: 34351 queue: default ...

1.通过本地客户那端命令连接 hive -e ‘select count(*) from *** where ***’ 或者 本地 敲命令 hive 然后 写 sql 方式 或者 bin/hive -e “HQL语句,多个语句用;...hive-1.1.0-cdh5.14.0]# bin/hive -f /export...

PBS任务只排队,不运行

标签: linux

PBS调度问题问题描述网上常见的解答调试过程任务列表查询任务调度系统...链接中提到的是任务提交失败,修改时区后能正常提交任务,但是提交后的任务仍不能自动调度,只能通过qrun来手动调度。 调试过程 因为这几天输入

作为一个执行服务ExecutorService的实例,ThreadPoolExecutor的首要任务当然是提交任务进行处理,那么,在任务提交时,ThreadPoolExecutor的处理流程是怎样的?它是一味的开启线程进行处理,还是有一套完整的逻辑来...

yarn的提交流程 ...2.ApplicationMaster 向 RM 注册,然后拆分为内部各个子任务, AM 采用轮询的方式向 RM 申请和领取资源。 3.RM 为 AM 分配资源,以 Container 形式返回。 4.AM 申请到资源后,便与之对

小白入门PBS,一脸懵逼,记一下主要命令和脚本

在Pycharm里执行python程序提交到spark集群一直报错:requirement failed: Can only call getServletHandlers on a running MetricsSystem本地提交到本机Spark没问题。代码片段如下,用的spark官网的例子(点击打开...

打开链接: http://Desktop:8088/proxy/application_1588324196554_0005/ 点击图中 Queue后面的default 会看到队列100% 解决方案[1]: ...yarn application -kill application_1437456051228_...

spark-sql提交参数详解整理

在投递、查看、修改和删除任务时一般常用的操作。比如test1.sh比如test2.py。常用任务管理命令 nohup qsub top ps kill qdel

1#rasin 发表于 |只看该作者 |倒序浏览 |打印PBS 是公开源代码的作业管理系统,在此环境下运行,用户不...(1) qsub 命令—用于提交作业脚本命令格式:qsub [-a date_time] [-c interval] [-C directive_prefix][-...

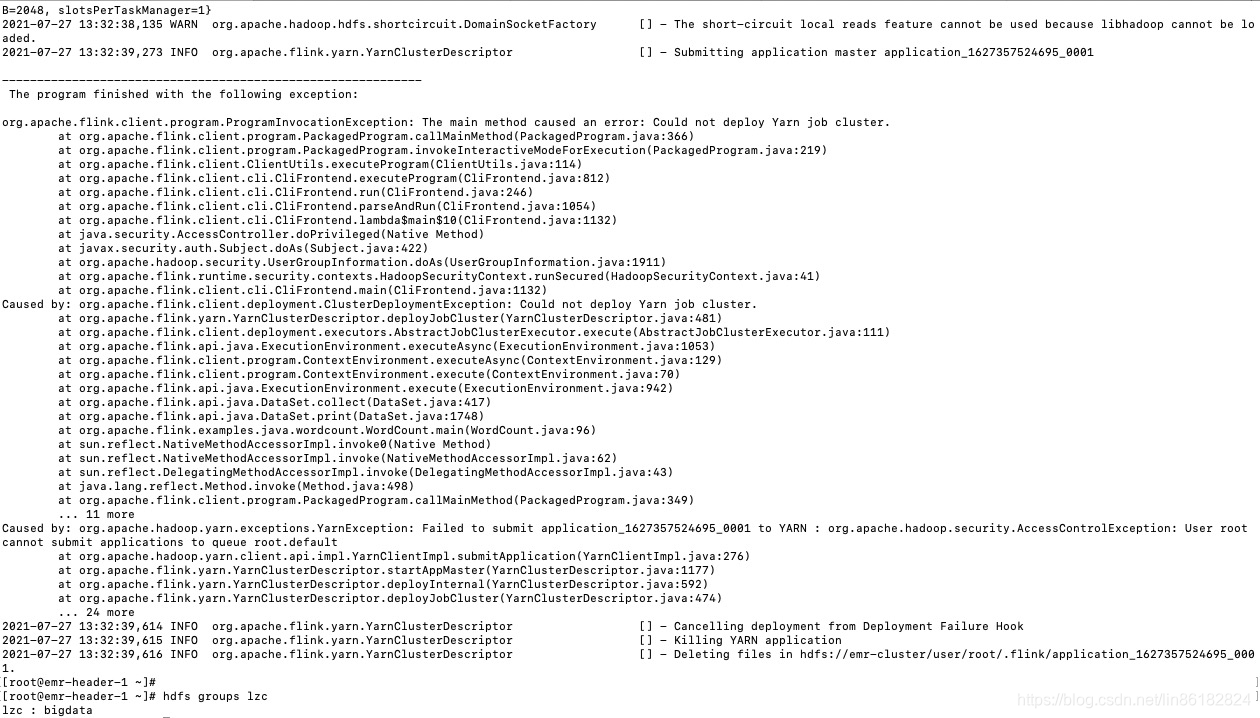

s(–slots): 每个 TaskManager 的 slot 数量,默认一个 slot 一个 core,默认每个。taskmanager 的 slot 的个数为 1,有时可以多一些 taskmanager,做冗余。-nm:yarn 的 appName(现在 yarn 的 ui 上的名字)。...

0x0 背景介绍 项目中使用SparkSession来执行任务,...为了解决以上问题,只有采用Java代码模拟Spark Submit来提交任务到集群,从而实现动态调用spark。 0x1 方法 查看多方资料,发现三个方法,分别是: 1. ...

spark提交代码的两种方式:Standalone、Yarn。

Flink 应用程序的作业可以被提交到长期运行的 Flink Session 集群、专用的 Flink Job 集群 或 Flink Application 集群。这些选项之间的差异主要与集群的生命周期和资源隔离保证有关。 一、Flink Session 集群 集群...

在使用spark处理数据的时候,大多数都是提交一个job执行,然后job内部会根据具体的任务,生成task任务,运行在多个进程中,比如读取的HDFS文件的数据,spark会加载所有的数据,然后根据block个数生成task数目,多个...

Spark中yarn模式两种提交任务方式(yarn-client与yarn-cluster) Spark可以和Yarn整合,将Application提交到Yarn上运行,和StandAlone提交模式一样,Yarn也有两种提交任务的方式。 1.yarn-client提交任务方式 ...

JAVA实现Spark的任务提交

推荐文章

- type-c转type A 3.0线以及otg线序_typec线序-程序员宅基地

- 软件测试周刊(第13期):质量是一种认知_conan流量回放-程序员宅基地

- python opencv图像对比度增强,用python(cv2)中的OpenCV增加彩色图像对比度的最快方法是什么?...-程序员宅基地

- [IDEA] chapter_reader - idea看小说阅读插件 - idea摸鱼插件_idea看小说插件-程序员宅基地

- 自学编程需要注意什么?_自学编程哪些注意-程序员宅基地

- 21.等值线图(Counter Plot)、Contour Demo、Creating a “meshgrid”、Calculation of the Values、等_counter图-程序员宅基地

- Vue刷新当前页面并带参_vue刷新页面并传递参数-程序员宅基地

- pktgen:DPDK流量生成器_pktgen-dpdk:22.04.1-程序员宅基地

- 判断URL中是否包含中文汉字_检测url中是否有中文-程序员宅基地

- hyperledger composer之查询语言_composer access control language-程序员宅基地