模型评估是对训练好的模型性能进行评估, 模型评估是模型开发过程不可或缺的一部分。它有助于发现表达数据的最佳模型和所选模型将来工作的性能如何。过拟合其实就是为了得到一致假设而使得假设过于地严格。使得其在...

”模型评估“ 的搜索结果

模型的准确率(Accuracy)是指模型在测试集上预测正确的样本数占总样本数的...那么准确率可以进一步细分为:准确率 = (真正例 + 真反例) / (真正例 + 真反例 + 假正例 + 假反例)准确率是评估模型性能的基本指标之一。

主要为大家详细介绍了TensorFlow实现模型评估,具有一定的参考价值,感兴趣的小伙伴们可以参考一下

机器学习模型评估是机器学习领域中的一个重要研究方向,其研究背景在于随着大数据时代的到来,人们面临着越来越多的数据分析和处理任务,而机器学习作为一种高效的数据处理技术,在很多领域都得到了广泛应用。...

详细讲解分类模型评估

标签: 分类 模型

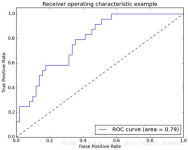

本篇博客让我们来学习分类模型评估。 涉及到的知识点有: 混淆矩阵 评估指标(正确率、准确率、召回率、调和平均值F1) ROC和AUC 那我们快开始吧! 分类模型评估1、分类模型主题:如何对分类模型进行评估目标:2、...

人工智能(AI)模型评估是一个关键的过程,用于确定模型在特定任务上的性能和有效性。这个过程涉及使用各种技术和指标来衡量模型的准确度、可靠性、泛化能力以及其他重要特性。在不同的应用场景中,模型评估的具体...

代码 基于Logistic回归模型评估企业还款能力代码代码 基于Logistic回归模型评估企业还款能力代码代码 基于Logistic回归模型评估企业还款能力代码代码 基于Logistic回归模型评估企业还款能力代码代码 基于Logistic...

DevOps 能力成熟度模型评估 标准 DevOps能力成熟度模型- 总体架构 -敏捷开发管理 过程-持续交付 技术运营 应用设计 安全 风险管理 组织结构。 研发运营一体化是指在IT软件及相关服务的研发及交付过程中,将应用的...

机器学习模型评估探究.zip

机器学习——模型评估与选择思维导图

知道每种评估指标的精确定义、有针对性地选择合适的评估指标、根据评估指标的反馈进行模型调整,这些都是机器学习在模型评估阶段的关键问题。 首先,我们先来了解一下关于模型评估的基础概念。 【误差(error)】:...

作者:禅与计算机程序设计艺术 ...基于 LightGBM 的模型评估与比较 引言 1.1. 背景介绍 随着深度学习模型的广泛应用,如何对模型的性能进行评估与比较成为了非常重要的问题。而 LightGBM 作为一种高效的

Chap02模型评估与选择.pptx

模型选择&&模型评估

标签: 算法

模型选择 模型评估

代码 基于Logistic回归模型评估企业还款能力 代码代码 基于Logistic回归模型评估企业还款能力 代码代码 基于Logistic回归模型评估企业还款能力 代码代码 基于Logistic回归模型评估企业还款能力 代码代码 基于...

大模型系列基础认知之一:大模型评估基础认知

建模的评估一般可以分为回归、分类和聚类的评估,本文主要介绍回归和分类的模型评估: 一、回归模型的评估 主要有以下方法: 指标 描述 metrics方法 Mean Absolute Error(MAE) 平均绝对误差 from ...

本教程将介绍深度学习模型的基本评估方法及它们的应用场景。我们主要关注监督学习模型。我们介绍了深度学习模型的常见评估指标,包括准确率、误差率、精确率、召回率、F1 分数、ROC 曲线和 AUC。这些指标可以帮助...

在AI场景下,我们同样需要定量的数值化指标,来指导我们更好地应用模型对数据进行学习和建模。本文讲解模型评估的一般流程,以及分类评估指标、回归评估指标的计算方式和适用场景。

模型评估与优化2–模型评估与选择 1.模型评估 模型在训练集上的误差通常称为 “训练误差” 或 “经验误差”,而在新样本上的误差称为 “泛化误差”。显然,机器学习的目的是得到泛化误差小的学习器。然而,在实际...

通常通过实验测试来对学习器的泛化误差进行评估并进而做出选择。为此,需要使用一个“测试集”(testing set)来测试学习器对新样本的判别能力,然后以测试集上的“测试误差”(testing error)作为泛化误差的近似。...

1 模型评价 2 评价指标 2.1 一级指标 序号 一级指标 真实值 模型预测值 说明 1 TP True Positive 真正,即真实值和预测值均是正样本,表示预测正确 2 TN True Negative 真负,即...

推荐文章

- 【解决报错】java.sql.SQLException: Access denied for user 'root'@'localhost' (using password: YES)-程序员宅基地

- echart y轴显示小数或整数_echarts y轴显示16位小数-程序员宅基地

- Android客户端和Internet的交互_android与internet-程序员宅基地

- linux新建分区步骤_linux创建基本分区的步骤-程序员宅基地

- 信号处理-小波变换4-DWT离散小波变换概念及离散小波变换实现滤波_dwt离散小波变换进行滤波-程序员宅基地

- Ubuntu 10.10中成功安装ns-allinone-2.34_进入/home/ubuntu1/ns-allinone-2.34目录cd /home/ubuntu1-程序员宅基地

- 使用AES算法对字符串进行加解密_java 判断aes加密 与否-程序员宅基地

- DFS深度优先搜索(前序、中序、后序遍历)非递归标准模板_深度优先搜索 无递归-程序员宅基地

- 程序员面试字节跳动,被怼了~_字节跳动java什么技术站-程序员宅基地

- 嵌入式软考备考(五)安全性基础知识-程序员宅基地